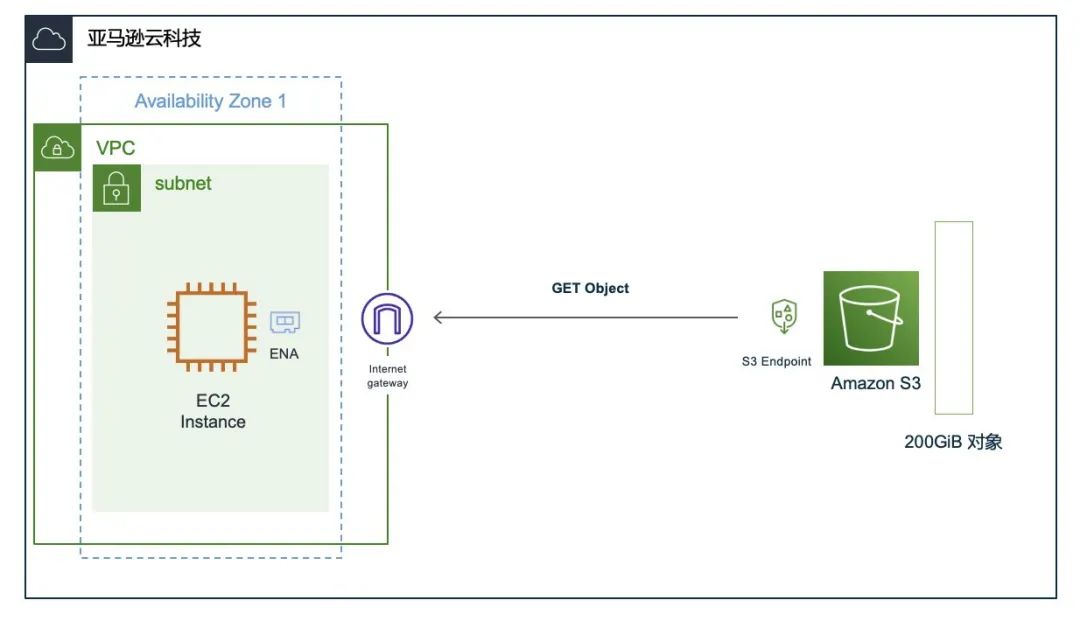

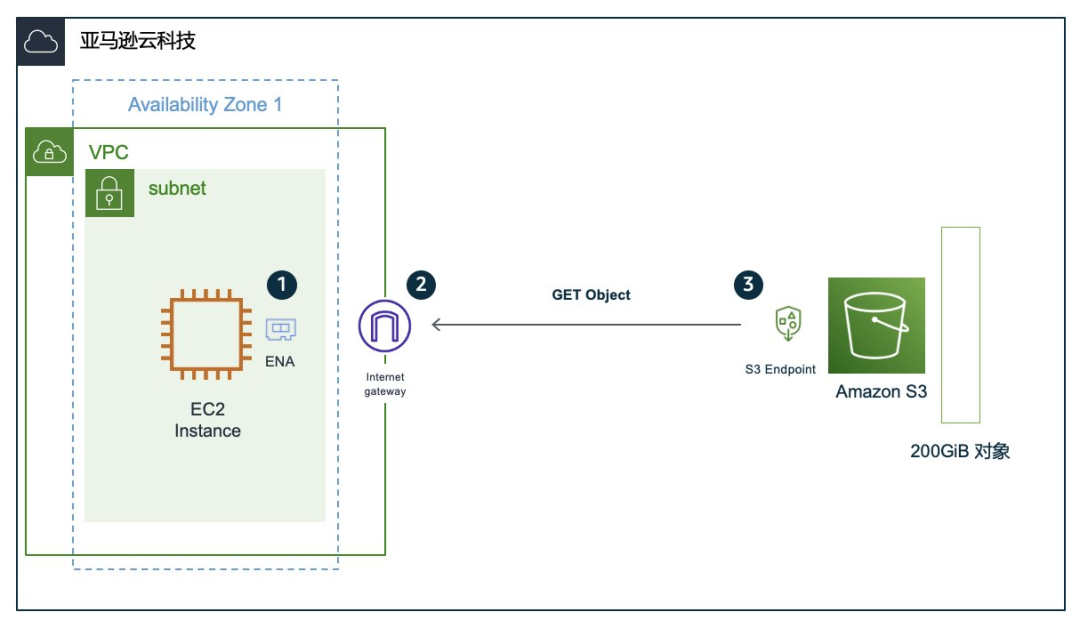

{"value":"### **前言**\n天下武功唯快不破,在很多应用场景中,如[机器学习](https://aws.amazon.com/cn/machine-learning/?trk=cndc-detail)、数据分析、高性能计算等,应用需要高速加载大量数据后进行本地计算。\n\n试想一下,您在亚马逊云科技上启动了一台 p4d.24xlarge (8 x NVIDIA A100 Tensor Core GPUs) 的实例,您立即拥有了一尊有 PetaFLOPS 级处理能力的性能怪兽,为了喂饱这个家伙,您在 **[Amazon Simple Storage Service](https://aws.amazon.com/cn/s3/?trk=cndc-detail) ([Amazon S3](https://aws.amazon.com/cn/s3/?trk=cndc-detail))** 上准备了 TB 级的基础数据,按200 GiB 一个对象拆分后存放。如果按照万兆10 G 网络的理论速度 1.16 GiB/s 的峰值性能来下载数据到本地,200 GiB 的单个对象需要大约172秒 ≈ 2.8分钟,那就意味着下载1 TiB 数据集总共需要等待14分钟左右,p4d.24xlarge 的按需实例报价大约是\$32.7/小时,也就是说,每小时里花了\$7.63等待数据到来后,您才能真正开始计算任务。\n\n改善数据等待的方法有很多,优化工作流程、调整数据 pipeline、边下载边计算都可以部分缓解这个问题,但随之而来的是需要更复杂的工作流程和更智慧的调度算法。\n\n但是,如果我们找到问题的核心,让数据下载更快,那一切都会直接变得简单了。\n\n经常有客户会问到: 把我存储在 **[Amazon Simple Storage Service](https://aws.amazon.com/cn/s3/?trk=cndc-detail) ([Amazon S3](https://aws.amazon.com/cn/s3/?trk=cndc-detail))** 上的数据下载到 **Amazon Elastic Compute Cloud (Amazon EC2)** 上,速度能有多快?\n\n答案是非常肯定的:在全球任何一个亚马逊云科技的区域里,[Amazon EC2 ](https://aws.amazon.com/cn/ec2/?trk=cndc-detail)到 [Amazon S3](https://aws.amazon.com/cn/s3/?trk=cndc-detail) 的默认数据**传输带宽都可以最高达到100 Gbps**([https://aws.amazon.com/cn/premiumsupport/knowledge-center/s3-maximum-transfer-speed-ec2/](https://aws.amazon.com/cn/premiumsupport/knowledge-center/s3-maximum-transfer-speed-ec2/))。\n\n“100 Gbps?! ”\n“在云上可以达到10万兆网络的传输速度?”\n\n那么接下去的问题是:需要怎么做才能达到这么高的传输带宽?\n\n本文希望通过梳理在云上进行高性能数据传输的一些背景知识和具体方法,帮助大家达成进行接近100 Gbps 线速的数据传输目标。为了验证最高的带宽,我们给自己设定了一个难题:将1个200 GiB 的对象存储在 S3 上,使用单进程应用,以最快的速度把这个对象下载到 EC2 上。\n\n\n\n图:整体架构\n\n为了达到我们设定的目标,我们先要回顾几个重要的关于亚马逊云科技服务和性能的知识点:\n\n#### **知识点1 [Amazon S3](https://aws.amazon.com/cn/s3/?trk=cndc-detail)**\n\n[Amazon S3](https://aws.amazon.com/cn/s3/?trk=cndc-detail) 是亚马逊云科技在2006年发布的第一个云服务,面向互联网海量用户同时使用的对象存储,在**2021 pi day 上披露的数据显示**([https://aws.amazon.com/cn/blogs/aws/amazon-s3s-15th-birthday-it-is-still-day-1-after-5475-days-100-trillion-objects/](https://aws.amazon.com/cn/blogs/aws/amazon-s3s-15th-birthday-it-is-still-day-1-after-5475-days-100-trillion-objects/)),S3 已经存储了超过 100 万亿个对象,达到每秒数千万个请求的经常性峰值。S3 为存储在上面的数据提供11个9的持久性和99.99%的可用性。\n\n用户与 S3 的所有交互通过基于 HTTP 的 S3 REST API 来实现,因为存取使用方便,提供很高的可用性与可靠性,按需计费,并且价格也很便宜,因此 S3 是客户长期持久化海量数据的首选服务。如今以 S3 为中心的数据湖架构也应用得越来越广泛,S3 持续发挥着作为互联网基石的作用。\n\n\n\n图:[Amazon S3](https://aws.amazon.com/cn/s3/?trk=cndc-detail)\n\n#### **知识点2 Amazon 的 VPC 网络**\nS3 和 EC2 在服务的网络上有很大不同,简而言之,EC2 的网络归属于用户的 VPC 中,通过 IP 网络与其他 EC2 或者亚马逊云科技的其他服务进行通讯和交互,而 S3 是一个独立服务并不存在于任何一个用户的 VPC 中,EC2 通过 S3 提供的 Endpoint 与 S3 进行通讯。\n\n从下面的架构图中我们可以看到,从 EC2 到 S3 的网络流量需要经过 EC2 的本机网卡 ENA(1) → 用户 VPC →网关(2) → S3 Endpoint(3)。\n\n在这个数据传输链路中,我们需要注意:\n\n1. 每款 EC2 实例类型都有可达到的最高带宽;\n2. 部分实例有基线带宽和突增带宽,通过网络 I/O 的 credits 机制控制可突增的时长。\n\n因此在构建数据传输之前,您需要了解您使用实例的网络性能上限,有关 EC2 实例网络带宽的更详细的介绍可以参看文档:\n\n[https://docs.aws.amazon.com/AWSEC2/latest/UserGuide/ec2-instance-network-bandwidth.html](https://docs.aws.amazon.com/AWSEC2/latest/UserGuide/ec2-instance-network-bandwidth.html)\n\n\n\n图:EC2 到 S3 的网络结构\n\n#### **知识点3 并发**\n在现代计算机的性能模型中,提高并发度是达成高性能的关键技术。并发的方式有多种多样,如线程级的并发、进程级的并发、节点级的并发,每一种并发的方式都有自己的并发模型,并与之配套有相应的同步机制和 I/O 请求模式。\n\n为了实现更好的整体性能,高性能应用通常会采用事件循环+非阻塞 I/O 的方式,相比传统应用的线程/进程+阻塞 I/O 的方式,前者可以极大提高单节点上的 I/O 处理能力。比如,大家熟悉的 redis, nginx 等都采用了事件循环的架构来实现高性能。\n\n\n\n图:Nginx Event Loop 介绍\n\n引用自:\n[https://www.nginx.com/blog/thread-pools-boost-performance-9x/](https://www.nginx.com/blog/thread-pools-boost-performance-9x/)\n\n我们的既定目标是:“将1个200 GiB 的对象存储在 S3 上,使用单进程应用,以最快的速度把这个对象下载到 EC2 上。” \n\n那么如果只有一个目标对象,如何能够实现并发访问或下载呢?\n\n#### **知识点4 并发访问 S3**\n对于 S3 来说在上传和下载路径都可以对单个对象进行分片操作,在上传路径,S3 通过 Multipart Upload 实现单个大对象的分片上传。\n\n\n\n图:S3 对象分段上传下载\n\n在下载路径上,S3 支持两种方式的分片下载。\n\n第一种,如果对象是以分片的方式进行上传的,那下载时可以按照原来分片上传的各个部分 (part) 来进行下载。\n\n第二种,S3 API 提供了 Bytes Range 的方式,可以自由指定一个对象中的某一段来进行下载。\n\n第一种方式略有局限,因为上传时的分片设置并不一定完全适合下载时使用,并且有时候我们可能仅需要一个对象中的某一小部分,而在 Bytes Range 的方式下,一次 API 请求可以指定对象的某一个连续区间进行下载,方便用户根据应用的需要进行适当调整。\n\n\n\n图:S3 对象按字节区间 (Byte Range) 下载\n\n为了应对全网海量用户的同时访问请求,在接入层,S3 的 Endpoint 提供了单一域名对应多个 IP 地址的方式来实现接入层的负载均衡。在实践中,通过 DNS 解析 S3 的 Endpoint 域名,大约每隔几秒钟会得到一个不同的 A 记录 (IPv 4地址)。因为 S3 提供了强一致性,所以用户可以放心从 Endpoint 解析出来的多个 IP 同时访问 S3。\n\n为了尽可能增加下载的并发度,以使传输能够达到最大的传输带宽,我们采取按 Bytes Range 分片下载对象,并尽可能把对每个分片下载请求发送到不同的 S3 Endpoint IP 地址上的方式来发起请求。因此,我们的数据请求模型变成了以下的模式。\n\n\n\n图:使用多个 IP 地址从 S3 按字节区间下载对象\n\n#### **知识点5 关于数据落盘**\n以100 Gbps 为例,如果您要在本机上保留下载数据的副本,那意味着您需要以 11.64 GiB/s 的速度在本地磁盘上保存这些数据。在实际场景中这是需要注意的:必须为计算节点配置与下载速率相匹配的本地存储。当然您如果采用流式计算或者不需要持久化数据到本地,那您可以忽略这部分内容。\n\n最后,在动手构建之前,我们还需要回答如下问题:\n\n- 没有现成的工具可以达到我们的预设目标吗?\n- 对于 S3 上的数据管理和使用,亚马逊云科技已经提供了完善的工具集, 包括了 Web Console, Amazon Command Line Interface (Amazon CLI) 工具以及各种语言的 Amazon SDK 等,使用现有的这些工具能否达到最高的带宽呢?\n\n答案是:可能非常困难。以 Amazon CLI 为例,默认情况下,使用 Amazon s3 cp 命令下载 S3 上的对象能够达到几百 MB/s 的级别。\n\n很多客户会有疑问,为什么亚马逊云科技自己提供的工具不能提供极限的性能?\n\n这里需要特别说明:\n\nAmazon CLI 提供了对亚马逊云科技所有服务 API 调用的命令行工具,针对 S3 这个服务,不但提供了相对底层,针对每个 S3 的 API 的命令行工具 (Amazon s3api) ,还进行了高级功能的封装 (Amazon s3) ,在 [Amazon S3](https://aws.amazon.com/cn/s3/?trk=cndc-detail) 命令集中实现了诸如目录同步等高级功能,因此 Amazon CLI 的重点在于提供简便高效的命令行工具,帮助客户轻松完成对亚马逊云科技服务的管理工作,并且工具自身能够快速迭代,紧跟亚马逊云科技新服务新特性的发布,而从 S3 上高性能下载数据,并非 Amazon CLI 的首要目标。\n\n其次,Amazon CLI 基于 python 语言实现,python 在多线程并发存在一定的局限性 ,接下来我们会详述。\n\n当然通过调整一些 Amazon CLI 的配置,我们还是可以让 Amazon CLI 的下载速度更快。比如,调整 CLI 的并发参数(默认10):\n\n```\\naws configure set default.s3.max_concurrent_requests 100\\n```\n下载速度得到很大提升,详细可以参考:\n[https://docs.aws.amazon.com/cli/latest/topic/s3-config.html](https://docs.aws.amazon.com/cli/latest/topic/s3-config.html)\n\n同时,采用多个 Amazon CLI 进程同时运行,并行下载多个对象,这也是平时我们常用的方法,同样能够提高整体的下载速率。在大部分场景下,如我们前面所述进程级的并发已经可以满足应用的需要。\n\n再来谈谈程序员们接触最多的 Amazon SDK,亚马逊云科技为所有的服务提供了丰富的计算语言 SDK 的支持,Amazon SDK 是对亚马逊云科技服务 API 的特定计算机语言的接口封装和实现,并提供了一些高级的功能简化开发人员的使用,但 SDK 需要维护自身的兼容性,并考虑对语言更广泛的支持,因此 SDK 通常不提供程序的运行时 (runtime) 、I/O 模型、线程模型等这些对极致性能至关重要的部分,这部分需要依赖程序员自己来实现。\n\n说到这里,要实现一个能够逼近线速下载的高性能应用的确不是一件很容易的事情,对于10万兆网络来说,普通应用使用的线程模型和 I/O 模型已经没法来应付了。接下去出场的是真正的主角:Amazon Common Runtime (CRT) 为了帮助我们的客户构建高性能的应用,亚马逊云科技提供的一套完整功能的应用基础库 Amazon Common Runtime (CRT)。\n\n[https://docs.aws.amazon.com/sdkref/latest/guide/common-runtime.html](https://docs.aws.amazon.com/sdkref/latest/guide/common-runtime.html) C 语言实现、模块化设计、Event Loop、线程/同步原语、内存管理等等。\n\nAmazon CRT 提供了构建一个高性能应用所需的一切轮子,并且基于这些基础的底层库,Amazon CRT 还重新实现应用经常会用到的模块, 包括 http 协议、checksum 校验算法、mqtt 协议、S3 协议等,为了提供更大的使用灵活性,Amazon CRT 也提供了与其他编程语言的 Bindings(语言接口绑定),目前已经集成的语言包括:C++, Java, python, ruby, nodejs, swift, c#, php, Kotlin,客户可以在 Amazon CRT 之上构建自己的高性能应用客户端或者服务端。\n\n\n\n图:Amazon CRT 模块结构\n您可能会问:为什么没有看到目前最火热两门高性能语言 Rust 与 Go?\n\n其实 FFI for Amazon CRT(Rust 语言绑定)已经有了,只是目前完成集成的功能还比较有限。总的来说,Rust 和 Go 在语言特性上已经提供高性能应用所必需的并发处理、同步原语等机制,为这两种语言提供一个高性能应用框架集成的迫切性并没有这么高,接下去的演示中我们也会使用亚马逊云科技原生的 Rust SDK 来实现对 S3 数据的并发下载来做对比。\n\n基于上面一系列的原因,为了突破现有应用框架带来的瓶颈,我们选择使用 Amazon CRT 来构建一个高性能的 S3 下载程序。\n\n**接下去,请各位绑好安全带,开启我们的100 Gbps 极速高性能之旅吧!**\n\n为了达到100 Gbps 的目标,我们选择 c5n.18xlarge 的 EC2 实例,在EC2实例家族中带 n 的实例都具有更高的网络性能,这款 c5n.18xlarge 的网络性能就可以达到100 Gbps,它的基本配置为:\n\n\n\n\n图:完整的验证架构\n使用 Amazon CRT 来构建一个高并发 S3 下载程序的基本逻辑和示例代码可以在 Amazon CRT 的 samples 里找到:\n[https://github.com/awslabs/aws-c-s3/tree/main/samples/s3](https://github.com/awslabs/aws-c-s3/tree/main/samples/s3)\n\n为了达到我们的测试目标,即获得最高的下载速率,我们基于 Amazon CRT 构建了一个特殊版本的测试程序,主要的不同有:\n\n1. 取消了数据下载后落盘的动作,避免数据落盘成为测试的瓶颈。\n2. 在每个分片下载完成后,记录下载完成的时间和完成的下载总量,用于计算下载所花的时间。\n3. 参数化分片大小和并发数量,用以调整以获得最高的性能。\n\n此外,\n\n1. 我们在 EC2 实例上安装了 [Amazon CloudWatch](https://aws.amazon.com/cn/cloudwatch/?trk=cndc-detail) Agent,用于采集操作系统的网络指标。\n2. 在 EC2 实例上安装。\n\n这里有一个小细节,我们前面提到,通过使用多个 S3 Endpoint IP 地址来分散 S3 的请求压力,Amazon CRT 其实也考虑到了这个问题,Amazon CRT 实现了一个 host resolver 模块,可以用来解析并缓存同一个域名的多个 A 记录,供应用在执行中循环使用,这个动作叫做 DNS 预热。\n\n进行 DNS 预热需要花一定的时间,而我们的验证程序希望能每次快速执行,快速验证并调整各种参数来比较结果,因此,我们的验证代码没有使用 Amazon CRT 的 host resolver,而是在测试实例上通过代码预先获取了一定数量的 S3 Endpoint 的 A 记录列表,并通过 dnsmasq 在本机提供域名解析服务的方式实现地址解析。但这并非生产环境中的最佳实践,作为一个大规模的云服务,S3 随时可能调整对外服务的 IP 地址,因此,实际应用当中请尽量从 DNS 服务器获取最新的 A 记录,避免某些 IP 地址失效影响应用正常执行。\n\n介绍到此完毕,**let’s go build !**\n完整的验证代码如下:\n\n```\\n#include <fcntl.h>\\n#include <unistd.h>\\n#include <aws/auth/credentials.h>\\n#include <aws/common/condition_variable.h>\\n#include <aws/common/mutex.h>\\n#include <aws/common/zero.h>\\n#include <aws/io/channel_bootstrap.h>\\n#include <aws/io/event_loop.h>\\n#include <aws/io/logging.h>\\n#include <aws/http/request_response.h>\\n#include <aws/s3/s3.h>\\n#include <aws/s3/s3_client.h>\\n#include <aws/common/private/thread_shared.h>\\n#include <aws/common/clock.h>\\n\\n#define TEST_REGION \\"ap-northeast-1\\"\\n#define TEST_S3_EP \\"testbucket.s3.ap-northeast-1.amazonaws.com\\"\\n#define TEST_MAIN_EP \\"s3.ap-northeast-1.amazonaws.com\\"\\n#define TEST_FILE \\"200G_test.file\\"\\n#define TEST_RESULT_FILE \\"test_stats.result\\"\\n#define TEST_RANGE_SIZE 8 * 1024 * 1024\\n\\nstruct perf_item {\\n uint64_t ns;\\n uint64_t len;\\n} __attribute__((packed, aligned(8)));\\n\\nstatic const struct aws_byte_cursor g_host_header_name = AWS_BYTE_CUR_INIT_FROM_STRING_LITERAL(\\"Host\\");\\n\\nstruct app_ctx {\\n struct aws_allocator *allocator;\\n struct aws_s3_client *client;\\n struct aws_credentials_provider *credentials_provider;\\n struct aws_client_bootstrap *client_bootstrap;\\n struct aws_logger logger;\\n struct aws_mutex mutex;\\n struct aws_condition_variable c_var;\\n bool execution_completed;\\n struct aws_signing_config_aws signing_config;\\n const char *region;\\n enum aws_log_level log_level;\\n bool help_requested;\\n void *sub_command_data;\\n size_t expected_transfers;\\n size_t completed_transfers;\\n};\\n\\nstruct transfer_ctx {\\n struct aws_s3_meta_request *meta_request;\\n struct app_ctx *app_ctx;\\n struct aws_atomic_var bytes_done;\\n struct aws_atomic_var index;\\n struct perf_item *stats;\\n};\\n\\nvoid s_get_request_finished(\\n struct aws_s3_meta_request *meta_request,\\n const struct aws_s3_meta_request_result *meta_request_result,\\n void *user_data) {\\n\\n struct transfer_ctx *transfer_ctx = user_data;\\n struct perf_item *items = transfer_ctx->stats;\\n int i = 0;\\n\\n uint32_t x = aws_atomic_load_int(&transfer_ctx->index);\\n\\n uint64_t total_ns = last - first;\\n double total_ms = total_ns / 1000.0 / 1000.0;\\n printf(\\"first: %ld, last: %ld, total ms: %.2lf\\\\n\\", first, last, total_ms);\\n\\n ssize_t total_bytes = aws_atomic_load_int(&transfer_ctx->bytes_done);\\n\\n double gbps = ((total_bytes / total_ms) * 1000) * 8 / 1000 / 1000 / 1000;\\n printf(\\"total bytes downloaded: %ld, line speed: %.2lf Gbps\\\\n\\", total_bytes, gbps);\\n\\n /* write test stats */\\n int fd;\\n fd = open(TEST_RESULT_FILE, O_CREAT | O_TRUNC | O_WRONLY);\\n write(fd, items, sizeof(struct perf_item) * x);\\n close(fd);\\n\\n transfer_ctx->app_ctx->completed_transfers++;\\n\\n aws_condition_variable_notify_one(&transfer_ctx->app_ctx->c_var);\\n aws_s3_meta_request_release(transfer_ctx->meta_request);\\n aws_mem_release(transfer_ctx->app_ctx->allocator, transfer_ctx->stats);\\n aws_mem_release(transfer_ctx->app_ctx->allocator, transfer_ctx);\\n\\n return;\\n}\\n\\nint s_get_body_callback(\\n struct aws_s3_meta_request *meta_request,\\n const struct aws_byte_cursor *body,\\n uint64_t range_start,\\n void *user_data) {\\n\\n struct transfer_ctx *transfer_ctx = user_data;\\n\\n uint64_t now;\\n size_t index;\\n\\n aws_high_res_clock_get_ticks(&now);\\n index = aws_atomic_fetch_add(&transfer_ctx->index, 1);\\n (transfer_ctx->stats)[index].ns = now;\\n (transfer_ctx->stats)[index].len = body->len;\\n\\n aws_atomic_fetch_add(&transfer_ctx->bytes_done, body->len);\\n\\n return AWS_OP_SUCCESS;\\n}\\n\\nbool s_are_all_transfers_done(void *arg) {\\n\\n struct app_ctx *app_ctx = arg;\\n\\n return app_ctx->expected_transfers == app_ctx->completed_transfers;\\n}\\n\\nint s3_get(struct app_ctx *app_ctx, struct aws_s3_client *client) {\\n char source_endpoint[1024];\\n AWS_ZERO_ARRAY(source_endpoint);\\n sprintf(source_endpoint, TEST_S3_EP);\\n\\n char main_endpoint[1024];\\n AWS_ZERO_ARRAY(main_endpoint);\\n sprintf(main_endpoint, TEST_MAIN_EP);\\n\\n struct aws_byte_cursor slash_cur = aws_byte_cursor_from_c_str(\\"/\\");\\n struct aws_byte_cursor keyname = aws_byte_cursor_from_c_str(TEST_FILE);\\n struct aws_byte_cursor *key = &keyname;\\n\\n struct transfer_ctx *xfer_ctx = aws_mem_calloc(app_ctx->allocator, 1, sizeof(struct transfer_ctx));\\n xfer_ctx->app_ctx = app_ctx;\\n\\n xfer_ctx->stats = aws_mem_calloc(app_ctx->allocator, 1000000, sizeof(struct perf_item));\\n aws_atomic_init_int(&xfer_ctx->bytes_done, 0);\\n aws_atomic_init_int(&xfer_ctx->index, 0);\\n\\n struct aws_s3_meta_request_options request_options = {\\n .user_data = xfer_ctx,\\n .signing_config = &app_ctx->signing_config,\\n .type = AWS_S3_META_REQUEST_TYPE_GET_OBJECT,\\n .finish_callback = s_get_request_finished,\\n .body_callback = s_get_body_callback,\\n .headers_callback = NULL,\\n .shutdown_callback = NULL,\\n .progress_callback = NULL,\\n };\\n\\n struct aws_http_header host_header = {\\n .name = g_host_header_name,\\n .value = aws_byte_cursor_from_c_str(source_endpoint),\\n };\\n\\n struct aws_http_header accept_header = {\\n .name = aws_byte_cursor_from_c_str(\\"accept\\"),\\n .value = aws_byte_cursor_from_c_str(\\"*/*\\"),\\n };\\n\\n struct aws_http_header user_agent_header = {\\n .name = aws_byte_cursor_from_c_str(\\"user-agent\\"),\\n .value = aws_byte_cursor_from_c_str(\\"AWS common runtime command-line client\\"),\\n };\\n\\n request_options.message = aws_http_message_new_request(app_ctx->allocator);\\n aws_http_message_add_header(request_options.message, host_header);\\n aws_http_message_add_header(request_options.message, accept_header);\\n aws_http_message_add_header(request_options.message, user_agent_header);\\n aws_http_message_set_request_method(request_options.message, aws_http_method_get);\\n\\n struct aws_byte_buf path_buf;\\n aws_byte_buf_init(&path_buf, app_ctx->allocator, key->len + 1);\\n aws_byte_buf_append_dynamic(&path_buf, &slash_cur);\\n aws_byte_buf_append_dynamic(&path_buf, key);\\n struct aws_byte_cursor path_cur = aws_byte_cursor_from_buf(&path_buf);\\n aws_http_message_set_request_path(request_options.message, path_cur);\\n aws_byte_buf_clean_up(&path_buf);\\n\\n struct aws_s3_meta_request *meta_request = aws_s3_client_make_meta_request(client, &request_options);\\n xfer_ctx->meta_request = meta_request;\\n\\n aws_mutex_lock(&app_ctx->mutex);\\n app_ctx->expected_transfers++;\\n aws_mutex_unlock(&app_ctx->mutex);\\n\\n aws_mutex_lock(&app_ctx->mutex);\\n aws_condition_variable_wait_pred(&app_ctx->c_var, &app_ctx->mutex, s_are_all_transfers_done, app_ctx);\\n aws_mutex_unlock(&app_ctx->mutex);\\n\\n return 0;\\n}\\n\\nint main() {\\n struct aws_allocator *allocator = aws_default_allocator();\\n aws_s3_library_init(allocator);\\n\\n struct app_ctx app_ctx;\\n AWS_ZERO_STRUCT(app_ctx);\\n app_ctx.allocator = allocator;\\n app_ctx.c_var = (struct aws_condition_variable)AWS_CONDITION_VARIABLE_INIT;\\n aws_mutex_init(&app_ctx.mutex);\\n app_ctx.expected_transfers = 0;\\n app_ctx.completed_transfers = 0;\\n\\n app_ctx.log_level = AWS_LOG_LEVEL_NONE;\\n\\n struct aws_logger_standard_options logger_options = {\\n .level = app_ctx.log_level,\\n .file = stderr,\\n };\\n\\n aws_logger_init_standard(&app_ctx.logger, app_ctx.allocator, &logger_options);\\n aws_logger_set(&app_ctx.logger);\\n\\n /* event loop */\\n struct aws_event_loop_group *event_loop_group = aws_event_loop_group_new_default(allocator, 0, NULL);\\n\\n /* resolver */\\n struct aws_host_resolver_default_options resolver_options = {\\n .el_group = event_loop_group,\\n .max_entries = 128,\\n };\\n struct aws_host_resolver *resolver = aws_host_resolver_new_default(allocator, &resolver_options);\\n\\n /* client bootstrap */\\n struct aws_client_bootstrap_options bootstrap_options = {\\n .event_loop_group = event_loop_group,\\n .host_resolver = resolver,\\n };\\n app_ctx.client_bootstrap = aws_client_bootstrap_new(allocator, &bootstrap_options);\\n if (app_ctx.client_bootstrap == NULL) {\\n printf(\\"ERROR initializing client bootstrap\\\\n\\");\\n return -1;\\n }\\n\\n /* credentials */\\n struct aws_credentials_provider_chain_default_options credentials_provider_options;\\n AWS_ZERO_STRUCT(credentials_provider_options);\\n credentials_provider_options.bootstrap = app_ctx.client_bootstrap;\\n app_ctx.credentials_provider = aws_credentials_provider_new_chain_default(allocator, &credentials_provider_options);\\n\\n /* signing config */\\n aws_s3_init_default_signing_config(\\n &app_ctx.signing_config, aws_byte_cursor_from_c_str(TEST_REGION), app_ctx.credentials_provider);\\n app_ctx.signing_config.flags.use_double_uri_encode = false;\\n\\n /* s3 client */\\n struct aws_s3_client_config client_config;\\n AWS_ZERO_STRUCT(client_config);\\n client_config.client_bootstrap = app_ctx.client_bootstrap;\\n client_config.region = aws_byte_cursor_from_c_str(TEST_REGION);\\n client_config.signing_config = &app_ctx.signing_config;\\n client_config.max_active_connections_override = 0;\\n client_config.throughput_target_gbps = 100;\\n client_config.part_size = TEST_RANGE_SIZE;\\n\\n struct aws_s3_client *client = aws_s3_client_new(app_ctx.allocator, &client_config);\\n app_ctx.client = client;\\n s3_get(&app_ctx, client);\\n\\n /* release resources */\\n aws_s3_client_release(app_ctx.client);\\n aws_credentials_provider_release(app_ctx.credentials_provider);\\n aws_client_bootstrap_release(app_ctx.client_bootstrap);\\n aws_host_resolver_release(resolver);\\n aws_event_loop_group_release(event_loop_group);\\n aws_mutex_clean_up(&app_ctx.mutex);\\n\\n aws_s3_library_clean_up();\\n\\n return 0;\\n}\\n```\n经过编译、执行后的最终的测试结果如下:\n```\\n[ec2-user@ip-172-31-32-214 clang]\$ ./s3bench\\nfirst: 30633404368026, last: 30653346831918, total ms: 19942.46\\ntotal bytes downloaded: 214748364800, line speed: 86.15 Gbps\\n```\n### **结果分析:**\n测试程序从收到第一个分片到最后一个分片一共花了19942.46毫秒,通过这个时间计算得到的平均下载速度是10.03 GiB/s,折合线速为 86.15 Gbps。\n\n同时通过 [Amazon CloudWatch](https://aws.amazon.com/cn/cloudwatch/?trk=cndc-detail) Agent 采集了操作系统的每秒接收字节数指标 (net_bytes_recv) ,并发送到 [Amazon CloudWatch](https://aws.amazon.com/cn/cloudwatch/?trk=cndc-detail) 做图形化分析。可以观察到测试过程中,每秒接收的字节数会有一小段缓慢上升的过程,这个阶段里由于测试程序刚刚启动,大量工作线程还在创建和初始化过程中,因此整个应用还未达到峰值的接收能力。而大约几秒种后,待工作线程初始化完毕,整个应用进入了稳定的工作状态,峰值接收速度稳定在94.73 Gbps,已经非常接近100 Gbps 的极值了。\n\n\n\n图:10万兆线速测试结果\n\n#### **BONUS #1**\nAmazon CRT 提供如此高的 I/O 性能,亚马逊云科技的开发人员也在积极向上层的亚马逊云科技工具集提供这种能力,其实今天在 Amazon CLI 中已经可以使用到 Amazon CRT,只是在 Amazon CLI 中使用 CRT 模式还处于 Experimental 阶段,在 Amazon CLI 中启用 CRT 模式有两个步骤:\n\n1. 升级到 Amazon CLI 到 v2 版本\n具体的升级步骤请参考文档:\n[https://docs.aws.amazon.com/cli/latest/userguide/cliv2-migration-instructions.html](https://docs.aws.amazon.com/cli/latest/userguide/cliv2-migration-instructions.html)\n\n2. 打开 CRT 模式\n```\\naws configure set default.s3.preferred_transfer_client crt\\n```\nCRT 模式的详细说明请参考文档:\n[https://awscli.amazonaws.com/v2/documentation/api/latest/topic/s3-config.html](https://awscli.amazonaws.com/v2/documentation/api/latest/topic/s3-config.html)\n\n设置完毕后, 运行 s3 cp 命令启动下载,发现速度已经有了明显的提升,在我们的测试实例上稳定在 2.0 GiB/s。\n```\\n[ec2-user@ip-172-31-40-21 ~]\$ aws s3 cp s3://testbucket/200_test.file /mnt/200_test.file\\nCompleted 29.6 GiB/200.0 GiB (2.0 GiB/s) with 1 file(s) remaining\\n```\n2 GiB/s 虽不及原生 Amazon CRT 能够达到的10 GiB/s,但对大部分使用场景来说已经够用,简单替换便能大幅提升性能,不失为一个简单的好办法。\n\n在好奇心的驱使下,我们分析了一下开启 CRT 模式的 Amazon CLI 遇到的瓶颈。在 Amazon CLI 稳定到下载峰值的时候,通过 gdb dump 了执行程序的调用链,我们看到,绝大部分的工作现场都处于 epoll_wait() 等待的状态。\n```\\n(gdb) info thread\\n Id Target Id Frame\\n* 1 Thread 0x7f467761e740 (LWP 18862) 0x00007f467645ea46 in do_futex_wait.constprop ()\\n from /lib64/libpthread.so.0\\n 2 Thread 0x7f45d8dfa700 (LWP 18904) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 3 Thread 0x7f45661fc700 (LWP 18926) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 4 Thread 0x7f45da1fc700 (LWP 18902) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 5 Thread 0x7f46561fc700 (LWP 18873) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 6 Thread 0x7f4657fff700 (LWP 18870) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 7 Thread 0x7f45d97fb700 (LWP 18903) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 8 Thread 0x7f4664e86700 (LWP 18868) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 9 Thread 0x7f46161fc700 (LWP 18890) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 10 Thread 0x7f45975fe700 (LWP 18912) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 11 Thread 0x7f4596bfd700 (LWP 18913) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 12 Thread 0x7f45db5fe700 (LWP 18900) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 13 Thread 0x7f44c21fc700 (LWP 18962) 0x00007f467645ea46 in do_futex_wait.constprop ()\\n from /lib64/libpthread.so.0\\n 14 Thread 0x7f451d7fb700 (LWP 18945) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 15 Thread 0x7f461ffff700 (LWP 18882) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 16 Thread 0x7f453d7fb700 (LWP 18939) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 17 Thread 0x7f457d7fb700 (LWP 18921) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 18 Thread 0x7f464f5fe700 (LWP 18876) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 19 Thread 0x7f45957fb700 (LWP 18915) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 20 Thread 0x7f4614dfa700 (LWP 18892) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 21 Thread 0x7f453ebfd700 (LWP 18937) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n```\n而 Amazon CLI 的主线程锁在信号量上,这是 python 著名的 GIL,关于 python GIL 这里不再赘述,Amazon CLI V2 仍然是基于 python 的实现,因此无法完全规避语言本身带来的多线程性能瓶颈。\n```\\n(gdb) thread 1\\n[Switching to thread 1 (Thread 0x7f467761e740 (LWP 18862))]\\n#0 0x00007f467645ea46 in do_futex_wait.constprop () from /lib64/libpthread.so.0\\n(gdb) bt\\n#0 0x00007f467645ea46 in do_futex_wait.constprop () from /lib64/libpthread.so.0\\n#1 0x00007f467645eb22 in __new_sem_wait_slow.constprop.0 () from /lib64/libpthread.so.0\\n#2 0x00007f46768812ff in PyThread_acquire_lock_timed (lock=lock@entry=0x561a67fcf390,\\n microseconds=microseconds@entry=-1000000, intr_flag=intr_flag@entry=1) at Python/thread_pthread.h:483\\n#3 0x00007f46768dcaf4 in acquire_timed (timeout=-1000000000, lock=0x561a67fcf390)\\n at ./Modules/_threadmodule.c:63\\n#4 lock_PyThread_acquire_lock (self=0x7f4664407ea0, args=<optimized out>, kwds=<optimized out>)\\n at ./Modules/_threadmodule.c:146\\n#5 0x00007f46767368a2 in method_vectorcall_VARARGS_KEYWORDS (func=0x7f46775c92c0, args=0x561a67ee7f48,\\n nargsf=<optimized out>, kwnames=<optimized out>) at Objects/descrobject.c:348\\n#6 0x00007f46766d80a8 in _PyObject_VectorcallTstate (kwnames=<optimized out>, nargsf=<optimized out>,\\n args=<optimized out>, callable=<optimized out>, tstate=<optimized out>)\\n at ./Include/cpython/abstract.h:118\\n#7 PyObject_Vectorcall (kwnames=<optimized out>, nargsf=<optimized out>, args=<optimized out>,\\n callable=<optimized out>) at ./Include/cpython/abstract.h:127\\n#8 trace_call_function (kwnames=<optimized out>, nargs=<optimized out>, args=<optimized out>,\\n func=<optimized out>, tstate=<optimized out>) at Python/ceval.c:5058\\n#9 call_function (kwnames=0x0, oparg=<optimized out>, pp_stack=<synthetic pointer>, tstate=0x561a674afe40)\\n at Python/ceval.c:5074\\n#10 _PyEval_EvalFrameDefault (tstate=<optimized out>, f=<optimized out>, throwflag=<optimized out>)\\n at Python/ceval.c:3506\\n#11 0x00007f467682aec1 in _PyEval_EvalFrame (throwflag=0, f=0x561a67ee7db0, tstate=0x561a674afe40)\\n at ./Include/internal/pycore_ceval.h:40\\n```\n但是,还是那句话,2 GiB/s 的下载速度对绝大部分使用场景已经够用,而且轻松配置几下就能获得,为什么不用呢?\n#### **BONUS #2**\n同样,在好奇心的驱使下,我们也验证了,自带无畏并发特性的 Rust 语言,在 S3 下载场景中的表现。验证代码如下:\n\n```\\nuse aws_config::meta::region::RegionProviderChain;\\nuse aws_sdk_s3::{Client, Region, PKG_VERSION};\\nuse aws_sdk_s3::Endpoint;\\nuse http::Uri;\\nuse tokio::runtime::{Builder, Runtime};\\nuse tokio::fs::File;\\nuse tokio::io::AsyncWriteExt;\\nuse tokio::io::AsyncSeekExt;\\nuse tokio::io::SeekFrom;\\nuse tokio::fs::OpenOptions;\\nuse tokio::time::{Duration, Instant};\\nuse std::error::Error;\\nuse indicatif::{ProgressBar, ProgressStyle};\\n\\nmacro_rules! thread_tasks {\\n (\$tasks:expr, \$manager:expr) => {{\\n let mut _tasks = Vec::new();\\n for i in 0..\$manager.threads {\\n let mut thread_tasks = Vec::new();\\n _tasks.push(thread_tasks);\\n }\\n let mut pos = 0;\\n for task in \$tasks {\\n let i = pos % \$manager.threads;\\n _tasks[i].push(task);\\n pos += 1;\\n }\\n _tasks\\n }}\\n}\\n\\ntype Range = (isize, isize);\\n\\ntype GetTask = Range;\\n\\n#[derive(Clone)]\\nstruct TransferManager {\\n s3: Client,\\n threads: usize,\\n chunks: isize,\\n bucket: String,\\n key: String,\\n filename: String,\\n objsz: isize,\\n forcewrite: bool,\\n bar: ProgressBar,\\n}\\n\\nimpl TransferManager {\\n\\n pub async fn new(is_get: bool, forcewrite: bool, filename: String, bucket: String, key: String, thread_cnt: usize, chunks: isize, endpoint: Option<String>) -> Self {\\n\\n let region_provider = RegionProviderChain::default_provider().or_else(\\"ap-northeast-1\\");\\n let shared_config = aws_config::from_env().region(region_provider).load().await;\\n\\n let client = if endpoint.is_some() {\\n let s3_config = aws_sdk_s3::config::Builder::from(&shared_config)\\n .endpoint_resolver(\\n Endpoint::immutable(Uri::try_from(endpoint.unwrap()).expect(\\"error: bad endpoint\\")),\\n )\\n .build();\\n Client::from_conf(s3_config)\\n } else {\\n Client::new(&shared_config)\\n };\\n\\n let mut manager = Self {\\n s3: client,\\n threads: thread_cnt,\\n chunks: chunks,\\n bucket: bucket.clone(),\\n key: key.clone(),\\n filename: filename.clone(),\\n objsz: 0,\\n forcewrite: forcewrite,\\n bar: ProgressBar::new(0),\\n };\\n\\n let mut objsz = 0;\\n if is_get {\\n objsz = manager.head_object().await;\\n if forcewrite {\\n let mut f = File::create(manager.filename.clone()).await.expect(\\"failed to create file\\");\\n f.set_len(objsz as u64).await.expect(\\"failed to set local file len\\");\\n }\\n } else {\\n objsz = manager.get_file_size().await;\\n }\\n\\n let bar = ProgressBar::new(objsz as u64);\\n bar.set_style(ProgressStyle::with_template(\\"{spinner:.green} [{elapsed_precise}] [{wide_bar:.cyan/blue}] {bytes}/{total_bytes} ({eta}) ({bytes_per_sec})\\")\\n .unwrap()\\n .progress_chars(\\"#>-\\"));\\n\\n manager.objsz = objsz;\\n manager.bar = bar;\\n manager\\n }\\n\\n pub fn alloc_get_tasks(&self, tasks: &mut Vec<GetTask>) {\\n\\n let mut remains = self.objsz;\\n let mut offset = 0;\\n while remains > 0 {\\n let mut range: Range = (0, 0);\\n if remains > self.chunks {\\n range = (offset, offset + self.chunks - 1);\\n } else {\\n range = (offset, offset + remains - 1);\\n }\\n let task = range;\\n tasks.push(task);\\n offset += self.chunks;\\n remains -= self.chunks;\\n }\\n }\\n\\n pub async fn do_get_tasks(&self) {\\n\\n let mut tasks = Vec::new();\\n\\n self.alloc_get_tasks(&mut tasks);\\n let mut thr_tasks: Vec<Vec<GetTask>> = thread_tasks!(tasks, self);\\n\\n let mut joins = Vec::new();\\n while let Some(mut thr_taskq) = thr_tasks.pop() {\\n let mut m = self.clone();\\n let bar = self.bar.clone();\\n let join = tokio::spawn(async move {\\n while let Some(task) = thr_taskq.pop() {\\n let res = m.download_object(task).await;\\n if res.is_err() {\\n println!(\\"download error: {:?}\\", res);\\n }\\n bar.inc(res.unwrap() as u64);\\n }\\n 0\\n });\\n joins.push(join);\\n }\\n\\n let instant = Instant::now();\\n self.bar.reset();\\n for join in joins {\\n join.await;\\n }\\n\\n let diff = instant.elapsed();\\n let bw = ((self.objsz as u128 / diff.as_millis()) as f64 / (1024.0 * 1024.0 * 1024.0)) * 1000.0;\\n self.bar.finish();\\n }\\n\\n pub async fn download_object(&mut self, range: GetTask) -> Result<isize, Box<dyn Error>> {\\n let resp = self.s3\\n .get_object()\\n .bucket(&self.bucket)\\n .key(&self.key)\\n .range(format!(\\"bytes={}-{}\\", range.0, range.1))\\n .send()\\n .await?;\\n let data = resp.body.collect().await.expect(\\"error reading data\\");\\n let mut bytes = data.into_bytes();\\n\\n if !self.forcewrite {\\n return Ok(bytes.len() as isize);\\n }\\n\\n let mut file = OpenOptions::new()\\n .write(true)\\n .open(self.filename.clone())\\n .await?;\\n\\n file.seek(SeekFrom::Start(range.0 as u64)).await?;\\n file.write_all(&bytes).await?;\\n\\n Ok(bytes.len() as isize)\\n }\\n\\n pub async fn head_object(&self) -> isize {\\n let resp = self.s3\\n .head_object()\\n .bucket(&self.bucket)\\n .key(&self.key)\\n .send()\\n .await\\n .expect(\\"failed to get object size from S3\\");\\n resp.content_length() as isize\\n }\\n\\n pub async fn get_file_size(&self) -> isize {\\n let attr = tokio::fs::metadata(self.filename.clone()).await.expect(\\"failed to get file size\\");\\n attr.len() as isize\\n }\\n}\\n\\nfn main() -> Result<(), Box<dyn Error>> {\\n\\n let is_get = true;\\n let mut region = \\"ap-northeast-1\\".to_string();\\n let mut bucket = \\"testbucket\\".to_string();\\n let mut object = \\"200G_test.file\\".to_string();\\n let mut filename = \\"200G_test.file\\".to_string();\\n let mut forcewrite = false;\\n let mut threadpool = 30;\\n let mut parallel_tasks = 300;\\n let mut chunksize = 8 * 1024 * 1024;\\n let mut endpoint = None;\\n\\n let rt = Builder::new_multi_thread()\\n .worker_threads(threadpool)\\n .enable_all()\\n .build()\\n .unwrap();\\n\\n rt.block_on(async {\\n let mut tm = TransferManager::new(is_get, forcewrite, filename, bucket, object, parallel_tasks, chunksize, endpoint).await;\\n\\n tm.do_get_tasks().await;\\n });\\n Ok(())\\n}\\n```\n运行结果如下:\n```\\n[ec2-user@ip-172-31-32-214 src]\$./s3perf\\n [00:00:24] [#######################################################################] 200.00 GiB/200.00 GiB (0s) (8.24 GiB/s)\\n [ec2-user@ip-172-31-32-214 src]\$\\n```\n200 GiB 的对象下载花了24秒,整体下载速度为 8.24 GiB/s,而在更客观的 CloudWatch 监控数据中我们看到了峰值**80.62 Gbps**。\n\n\n\n从结果看到,Rust 语言的表现也非常优秀。\n\n### **总结**\n我们目标是通过验证的工作,帮助大家了解在 EC2 到 S3 之间实现逼近100 Gbps 线速数据传输的一切细节,回归问题的本质,对于客户实际应用场景来说,是否真正需要追求极限性能,如何利用好现有的资源达到应用最优的效果,是值得思考的问题。\n\n我们的建议是:\n\n1. 应该首先分析应用的场景,确定极限性能的必要性,对于绝大部分应用场景来说,目前亚马逊云科技提供的 CLI 或者 SDK 已经可以满足客户的需求,或者通过一定的参数调整即可满足对性能的要求。\n\n2. 现有工具和方法可以满足应用需求的前提下,不必盲目追求极限的性能,毕竟使用 Amazon CRT 改造应用需要重构代码及应用,会带来额外的改造成本和测试集成的成本。\n\n3. 我们验证的场景是 EC2 上单应用进程对 S3 上单个大对象的下载,在更具普适性的场景中,使用多进程同时下载多个对象方式也是有效提高并发度,进而提高系统整体吞吐率的有效方式。\n\n4. 对于确实需要极限性能的场景,建议您尽早考虑使用 Amazon CRT 来重构核心的模块,实现最高的性能。\n\n随着 Amazon CRT 的不断发展,我们相信它的易用性以及与现有语言和应用生态的集成会做的越来越好,我们也期待有越来越多的客户使用 Amazon CRT 来构建高性能的应用。\n\n### **本篇作者**\n\n\n\n**戴逸洋**\n亚马逊云科技数据存储资深架构师,致力于推广存储技术在云上的各种最佳实践。\n\n[阅读原文](https://aws.amazon.com/cn/blogs/china/pushing-the-data-transfer-from-amazon-ec2-to-amazon-s3-to-100gbps-line-speed/?sc_channel=sm&sc_campaign=blog&sc_publisher=wechatdev&sc_detail=)","render":"<h3><a id=\\"_0\\"></a><strong>前言</strong></h3>\\n<p>天下武功唯快不破,在很多应用场景中,如机器学习、数据分析、高性能计算等,应用需要高速加载大量数据后进行本地计算。</p>\n<p>试想一下,您在亚马逊云科技上启动了一台 p4d.24xlarge (8 x NVIDIA A100 Tensor Core GPUs) 的实例,您立即拥有了一尊有 PetaFLOPS 级处理能力的性能怪兽,为了喂饱这个家伙,您在 <strong>Amazon Simple Storage Service (Amazon S3)</strong> 上准备了 TB 级的基础数据,按200 GiB 一个对象拆分后存放。如果按照万兆10 G 网络的理论速度 1.16 GiB/s 的峰值性能来下载数据到本地,200 GiB 的单个对象需要大约172秒 ≈ 2.8分钟,那就意味着下载1 TiB 数据集总共需要等待14分钟左右,p4d.24xlarge 的按需实例报价大约是\$32.7/小时,也就是说,每小时里花了\$7.63等待数据到来后,您才能真正开始计算任务。</p>\\n<p>改善数据等待的方法有很多,优化工作流程、调整数据 pipeline、边下载边计算都可以部分缓解这个问题,但随之而来的是需要更复杂的工作流程和更智慧的调度算法。</p>\n<p>但是,如果我们找到问题的核心,让数据下载更快,那一切都会直接变得简单了。</p>\n<p>经常有客户会问到: 把我存储在 <strong>Amazon Simple Storage Service (Amazon S3)</strong> 上的数据下载到 <strong>Amazon Elastic Compute Cloud (Amazon EC2)</strong> 上,速度能有多快?</p>\\n<p>答案是非常肯定的:在全球任何一个亚马逊云科技的区域里,Amazon EC2 到 Amazon S3 的默认数据<strong>传输带宽都可以最高达到100 Gbps</strong>(<a href=\\"https://aws.amazon.com/cn/premiumsupport/knowledge-center/s3-maximum-transfer-speed-ec2/\\" target=\\"_blank\\">https://aws.amazon.com/cn/premiumsupport/knowledge-center/s3-maximum-transfer-speed-ec2/</a>)。</p>\\n<p>“100 Gbps?! ”<br />\\n“在云上可以达到10万兆网络的传输速度?”</p>\n<p>那么接下去的问题是:需要怎么做才能达到这么高的传输带宽?</p>\n<p>本文希望通过梳理在云上进行高性能数据传输的一些背景知识和具体方法,帮助大家达成进行接近100 Gbps 线速的数据传输目标。为了验证最高的带宽,我们给自己设定了一个难题:将1个200 GiB 的对象存储在 S3 上,使用单进程应用,以最快的速度把这个对象下载到 EC2 上。</p>\n<p><img src=\\"https://dev-media.amazoncloud.cn/988108c556d94d3f8331c74adc1a79f5_e04ee641f974125cf1484832fa234ba5.jpg\\" alt=\\"e04ee641f974125cf1484832fa234ba5.jpg\\" /></p>\n<p>图:整体架构</p>\n<p>为了达到我们设定的目标,我们先要回顾几个重要的关于亚马逊云科技服务和性能的知识点:</p>\n<h4><a id=\\"1_Amazon_S3_26\\"></a><strong>知识点1 Amazon S3</strong></h4>\\n<p>Amazon S3 是亚马逊云科技在2006年发布的第一个云服务,面向互联网海量用户同时使用的对象存储,在<strong>2021 pi day 上披露的数据显示</strong>(<a href=\\"https://aws.amazon.com/cn/blogs/aws/amazon-s3s-15th-birthday-it-is-still-day-1-after-5475-days-100-trillion-objects/\\" target=\\"_blank\\">https://aws.amazon.com/cn/blogs/aws/amazon-s3s-15th-birthday-it-is-still-day-1-after-5475-days-100-trillion-objects/</a>),S3 已经存储了超过 100 万亿个对象,达到每秒数千万个请求的经常性峰值。S3 为存储在上面的数据提供11个9的持久性和99.99%的可用性。</p>\\n<p>用户与 S3 的所有交互通过基于 HTTP 的 S3 REST API 来实现,因为存取使用方便,提供很高的可用性与可靠性,按需计费,并且价格也很便宜,因此 S3 是客户长期持久化海量数据的首选服务。如今以 S3 为中心的数据湖架构也应用得越来越广泛,S3 持续发挥着作为互联网基石的作用。</p>\n<p><img src=\\"https://dev-media.amazoncloud.cn/b9b5b5d1a70a465d9b9d9d48dd8b2eca_077991f23968720659ba41bcce48a205.png\\" alt=\\"077991f23968720659ba41bcce48a205.png\\" /></p>\n<p>图:Amazon S3</p>\n<h4><a id=\\"2_Amazon__VPC__36\\"></a><strong>知识点2 Amazon 的 VPC 网络</strong></h4>\\n<p>S3 和 EC2 在服务的网络上有很大不同,简而言之,EC2 的网络归属于用户的 VPC 中,通过 IP 网络与其他 EC2 或者亚马逊云科技的其他服务进行通讯和交互,而 S3 是一个独立服务并不存在于任何一个用户的 VPC 中,EC2 通过 S3 提供的 Endpoint 与 S3 进行通讯。</p>\n<p>从下面的架构图中我们可以看到,从 EC2 到 S3 的网络流量需要经过 EC2 的本机网卡 ENA(1) → 用户 VPC →网关(2) → S3 Endpoint(3)。</p>\n<p>在这个数据传输链路中,我们需要注意:</p>\n<ol>\\n<li>每款 EC2 实例类型都有可达到的最高带宽;</li>\n<li>部分实例有基线带宽和突增带宽,通过网络 I/O 的 credits 机制控制可突增的时长。</li>\n</ol>\\n<p>因此在构建数据传输之前,您需要了解您使用实例的网络性能上限,有关 EC2 实例网络带宽的更详细的介绍可以参看文档:</p>\n<p><a href=\\"https://docs.aws.amazon.com/AWSEC2/latest/UserGuide/ec2-instance-network-bandwidth.html\\" target=\\"_blank\\">https://docs.aws.amazon.com/AWSEC2/latest/UserGuide/ec2-instance-network-bandwidth.html</a></p>\\n<p><img src=\\"https://dev-media.amazoncloud.cn/99ba5117b613463f899a70c4ed9e68fa_a4bf91364b0f9b10c93ffdafc99b072c.png\\" alt=\\"a4bf91364b0f9b10c93ffdafc99b072c.png\\" /></p>\n<p>图:EC2 到 S3 的网络结构</p>\n<h4><a id=\\"3__54\\"></a><strong>知识点3 并发</strong></h4>\\n<p>在现代计算机的性能模型中,提高并发度是达成高性能的关键技术。并发的方式有多种多样,如线程级的并发、进程级的并发、节点级的并发,每一种并发的方式都有自己的并发模型,并与之配套有相应的同步机制和 I/O 请求模式。</p>\n<p>为了实现更好的整体性能,高性能应用通常会采用事件循环+非阻塞 I/O 的方式,相比传统应用的线程/进程+阻塞 I/O 的方式,前者可以极大提高单节点上的 I/O 处理能力。比如,大家熟悉的 redis, nginx 等都采用了事件循环的架构来实现高性能。</p>\n<p><img src=\\"https://dev-media.amazoncloud.cn/09147541fa2c4e34936c38a4eb60daa9_3fe38b6190a8c387687fbc343fe59d9e.png\\" alt=\\"3fe38b6190a8c387687fbc343fe59d9e.png\\" /></p>\n<p>图:Nginx Event Loop 介绍</p>\n<p>引用自:<br />\\n<a href=\\"https://www.nginx.com/blog/thread-pools-boost-performance-9x/\\" target=\\"_blank\\">https://www.nginx.com/blog/thread-pools-boost-performance-9x/</a></p>\\n<p>我们的既定目标是:“将1个200 GiB 的对象存储在 S3 上,使用单进程应用,以最快的速度把这个对象下载到 EC2 上。”</p>\n<p>那么如果只有一个目标对象,如何能够实现并发访问或下载呢?</p>\n<h4><a id=\\"4__S3_70\\"></a><strong>知识点4 并发访问 S3</strong></h4>\\n<p>对于 S3 来说在上传和下载路径都可以对单个对象进行分片操作,在上传路径,S3 通过 Multipart Upload 实现单个大对象的分片上传。</p>\n<p><img src=\\"https://dev-media.amazoncloud.cn/cfe1c9785e124fcf9c75fda868ae49b2_116791067ec39dd3e46e3eb20d02ce00.png\\" alt=\\"116791067ec39dd3e46e3eb20d02ce00.png\\" /></p>\n<p>图:S3 对象分段上传下载</p>\n<p>在下载路径上,S3 支持两种方式的分片下载。</p>\n<p>第一种,如果对象是以分片的方式进行上传的,那下载时可以按照原来分片上传的各个部分 (part) 来进行下载。</p>\n<p>第二种,S3 API 提供了 Bytes Range 的方式,可以自由指定一个对象中的某一段来进行下载。</p>\n<p>第一种方式略有局限,因为上传时的分片设置并不一定完全适合下载时使用,并且有时候我们可能仅需要一个对象中的某一小部分,而在 Bytes Range 的方式下,一次 API 请求可以指定对象的某一个连续区间进行下载,方便用户根据应用的需要进行适当调整。</p>\n<p><img src=\\"https://dev-media.amazoncloud.cn/c510f6a260ab43889db2454eb09a887e_2b298465ea3288ba61594805919610b7.jpg\\" alt=\\"2b298465ea3288ba61594805919610b7.jpg\\" /></p>\n<p>图:S3 对象按字节区间 (Byte Range) 下载</p>\n<p>为了应对全网海量用户的同时访问请求,在接入层,S3 的 Endpoint 提供了单一域名对应多个 IP 地址的方式来实现接入层的负载均衡。在实践中,通过 DNS 解析 S3 的 Endpoint 域名,大约每隔几秒钟会得到一个不同的 A 记录 (IPv 4地址)。因为 S3 提供了强一致性,所以用户可以放心从 Endpoint 解析出来的多个 IP 同时访问 S3。</p>\n<p>为了尽可能增加下载的并发度,以使传输能够达到最大的传输带宽,我们采取按 Bytes Range 分片下载对象,并尽可能把对每个分片下载请求发送到不同的 S3 Endpoint IP 地址上的方式来发起请求。因此,我们的数据请求模型变成了以下的模式。</p>\n<p><img src=\\"https://dev-media.amazoncloud.cn/3143e94fa0c34cdca67677203be6edbd_1c8223c7b2ae9b3977a311ac1667cba1.png\\" alt=\\"1c8223c7b2ae9b3977a311ac1667cba1.png\\" /></p>\n<p>图:使用多个 IP 地址从 S3 按字节区间下载对象</p>\n<h4><a id=\\"5__97\\"></a><strong>知识点5 关于数据落盘</strong></h4>\\n<p>以100 Gbps 为例,如果您要在本机上保留下载数据的副本,那意味着您需要以 11.64 GiB/s 的速度在本地磁盘上保存这些数据。在实际场景中这是需要注意的:必须为计算节点配置与下载速率相匹配的本地存储。当然您如果采用流式计算或者不需要持久化数据到本地,那您可以忽略这部分内容。</p>\n<p>最后,在动手构建之前,我们还需要回答如下问题:</p>\n<ul>\\n<li>没有现成的工具可以达到我们的预设目标吗?</li>\n<li>对于 S3 上的数据管理和使用,亚马逊云科技已经提供了完善的工具集, 包括了 Web Console, Amazon Command Line Interface (Amazon CLI) 工具以及各种语言的 Amazon SDK 等,使用现有的这些工具能否达到最高的带宽呢?</li>\n</ul>\\n<p>答案是:可能非常困难。以 Amazon CLI 为例,默认情况下,使用 Amazon s3 cp 命令下载 S3 上的对象能够达到几百 MB/s 的级别。</p>\n<p>很多客户会有疑问,为什么亚马逊云科技自己提供的工具不能提供极限的性能?</p>\n<p>这里需要特别说明:</p>\n<p>Amazon CLI 提供了对亚马逊云科技所有服务 API 调用的命令行工具,针对 S3 这个服务,不但提供了相对底层,针对每个 S3 的 API 的命令行工具 (Amazon s3api) ,还进行了高级功能的封装 (Amazon s3) ,在 Amazon S3 命令集中实现了诸如目录同步等高级功能,因此 Amazon CLI 的重点在于提供简便高效的命令行工具,帮助客户轻松完成对亚马逊云科技服务的管理工作,并且工具自身能够快速迭代,紧跟亚马逊云科技新服务新特性的发布,而从 S3 上高性能下载数据,并非 Amazon CLI 的首要目标。</p>\n<p>其次,Amazon CLI 基于 python 语言实现,python 在多线程并发存在一定的局限性 ,接下来我们会详述。</p>\n<p>当然通过调整一些 Amazon CLI 的配置,我们还是可以让 Amazon CLI 的下载速度更快。比如,调整 CLI 的并发参数(默认10):</p>\n<pre><code class=\\"lang-\\">aws configure set default.s3.max_concurrent_requests 100\\n</code></pre>\\n<p>下载速度得到很大提升,详细可以参考:<br />\\n<a href=\\"https://docs.aws.amazon.com/cli/latest/topic/s3-config.html\\" target=\\"_blank\\">https://docs.aws.amazon.com/cli/latest/topic/s3-config.html</a></p>\\n<p>同时,采用多个 Amazon CLI 进程同时运行,并行下载多个对象,这也是平时我们常用的方法,同样能够提高整体的下载速率。在大部分场景下,如我们前面所述进程级的并发已经可以满足应用的需要。</p>\n<p>再来谈谈程序员们接触最多的 Amazon SDK,亚马逊云科技为所有的服务提供了丰富的计算语言 SDK 的支持,Amazon SDK 是对亚马逊云科技服务 API 的特定计算机语言的接口封装和实现,并提供了一些高级的功能简化开发人员的使用,但 SDK 需要维护自身的兼容性,并考虑对语言更广泛的支持,因此 SDK 通常不提供程序的运行时 (runtime) 、I/O 模型、线程模型等这些对极致性能至关重要的部分,这部分需要依赖程序员自己来实现。</p>\n<p>说到这里,要实现一个能够逼近线速下载的高性能应用的确不是一件很容易的事情,对于10万兆网络来说,普通应用使用的线程模型和 I/O 模型已经没法来应付了。接下去出场的是真正的主角:Amazon Common Runtime (CRT) 为了帮助我们的客户构建高性能的应用,亚马逊云科技提供的一套完整功能的应用基础库 Amazon Common Runtime (CRT)。</p>\n<p><a href=\\"https://docs.aws.amazon.com/sdkref/latest/guide/common-runtime.html\\" target=\\"_blank\\">https://docs.aws.amazon.com/sdkref/latest/guide/common-runtime.html</a> C 语言实现、模块化设计、Event Loop、线程/同步原语、内存管理等等。</p>\\n<p>Amazon CRT 提供了构建一个高性能应用所需的一切轮子,并且基于这些基础的底层库,Amazon CRT 还重新实现应用经常会用到的模块, 包括 http 协议、checksum 校验算法、mqtt 协议、S3 协议等,为了提供更大的使用灵活性,Amazon CRT 也提供了与其他编程语言的 Bindings(语言接口绑定),目前已经集成的语言包括:C++, Java, python, ruby, nodejs, swift, c#, php, Kotlin,客户可以在 Amazon CRT 之上构建自己的高性能应用客户端或者服务端。</p>\n<p><img src=\\"https://dev-media.amazoncloud.cn/72b88aa62f2c43629e20ac01ef4bdc82_557de0f9746e1f47317b3dc1ffb38d6b.png\\" alt=\\"557de0f9746e1f47317b3dc1ffb38d6b.png\\" /></p>\n<p>图:Amazon CRT 模块结构<br />\\n您可能会问:为什么没有看到目前最火热两门高性能语言 Rust 与 Go?</p>\n<p>其实 FFI for Amazon CRT(Rust 语言绑定)已经有了,只是目前完成集成的功能还比较有限。总的来说,Rust 和 Go 在语言特性上已经提供高性能应用所必需的并发处理、同步原语等机制,为这两种语言提供一个高性能应用框架集成的迫切性并没有这么高,接下去的演示中我们也会使用亚马逊云科技原生的 Rust SDK 来实现对 S3 数据的并发下载来做对比。</p>\n<p>基于上面一系列的原因,为了突破现有应用框架带来的瓶颈,我们选择使用 Amazon CRT 来构建一个高性能的 S3 下载程序。</p>\n<p><strong>接下去,请各位绑好安全带,开启我们的100 Gbps 极速高性能之旅吧!</strong></p>\\n<p>为了达到100 Gbps 的目标,我们选择 c5n.18xlarge 的 EC2 实例,在EC2实例家族中带 n 的实例都具有更高的网络性能,这款 c5n.18xlarge 的网络性能就可以达到100 Gbps,它的基本配置为:</p>\n<p><img src=\\"https://dev-media.amazoncloud.cn/e22ac17653d14e2eaa66ccf3359133e9_a57618e420b1dbf57b5118d36d6d8c0a.jpg\\" alt=\\"a57618e420b1dbf57b5118d36d6d8c0a.jpg\\" /><br />\\n<img src=\\"https://dev-media.amazoncloud.cn/267628207e86487ab436569a51f370c6_cac4114d2acdea07f3cac7d857a8e845.png\\" alt=\\"cac4114d2acdea07f3cac7d857a8e845.png\\" /></p>\n<p>图:完整的验证架构<br />\\n使用 Amazon CRT 来构建一个高并发 S3 下载程序的基本逻辑和示例代码可以在 Amazon CRT 的 samples 里找到:<br />\\n<a href=\\"https://github.com/awslabs/aws-c-s3/tree/main/samples/s3\\" target=\\"_blank\\">https://github.com/awslabs/aws-c-s3/tree/main/samples/s3</a></p>\\n<p>为了达到我们的测试目标,即获得最高的下载速率,我们基于 Amazon CRT 构建了一个特殊版本的测试程序,主要的不同有:</p>\n<ol>\\n<li>取消了数据下载后落盘的动作,避免数据落盘成为测试的瓶颈。</li>\n<li>在每个分片下载完成后,记录下载完成的时间和完成的下载总量,用于计算下载所花的时间。</li>\n<li>参数化分片大小和并发数量,用以调整以获得最高的性能。</li>\n</ol>\\n<p>此外,</p>\n<ol>\\n<li>我们在 EC2 实例上安装了 Amazon CloudWatch Agent,用于采集操作系统的网络指标。</li>\n<li>在 EC2 实例上安装。</li>\n</ol>\\n<p>这里有一个小细节,我们前面提到,通过使用多个 S3 Endpoint IP 地址来分散 S3 的请求压力,Amazon CRT 其实也考虑到了这个问题,Amazon CRT 实现了一个 host resolver 模块,可以用来解析并缓存同一个域名的多个 A 记录,供应用在执行中循环使用,这个动作叫做 DNS 预热。</p>\n<p>进行 DNS 预热需要花一定的时间,而我们的验证程序希望能每次快速执行,快速验证并调整各种参数来比较结果,因此,我们的验证代码没有使用 Amazon CRT 的 host resolver,而是在测试实例上通过代码预先获取了一定数量的 S3 Endpoint 的 A 记录列表,并通过 dnsmasq 在本机提供域名解析服务的方式实现地址解析。但这并非生产环境中的最佳实践,作为一个大规模的云服务,S3 随时可能调整对外服务的 IP 地址,因此,实际应用当中请尽量从 DNS 服务器获取最新的 A 记录,避免某些 IP 地址失效影响应用正常执行。</p>\n<p>介绍到此完毕,<strong>let’s go build !</strong><br />\\n完整的验证代码如下:</p>\n<pre><code class=\\"lang-\\">#include <fcntl.h>\\n#include <unistd.h>\\n#include <aws/auth/credentials.h>\\n#include <aws/common/condition_variable.h>\\n#include <aws/common/mutex.h>\\n#include <aws/common/zero.h>\\n#include <aws/io/channel_bootstrap.h>\\n#include <aws/io/event_loop.h>\\n#include <aws/io/logging.h>\\n#include <aws/http/request_response.h>\\n#include <aws/s3/s3.h>\\n#include <aws/s3/s3_client.h>\\n#include <aws/common/private/thread_shared.h>\\n#include <aws/common/clock.h>\\n\\n#define TEST_REGION "ap-northeast-1"\\n#define TEST_S3_EP "testbucket.s3.ap-northeast-1.amazonaws.com"\\n#define TEST_MAIN_EP "s3.ap-northeast-1.amazonaws.com"\\n#define TEST_FILE "200G_test.file"\\n#define TEST_RESULT_FILE "test_stats.result"\\n#define TEST_RANGE_SIZE 8 * 1024 * 1024\\n\\nstruct perf_item {\\n uint64_t ns;\\n uint64_t len;\\n} __attribute__((packed, aligned(8)));\\n\\nstatic const struct aws_byte_cursor g_host_header_name = AWS_BYTE_CUR_INIT_FROM_STRING_LITERAL("Host");\\n\\nstruct app_ctx {\\n struct aws_allocator *allocator;\\n struct aws_s3_client *client;\\n struct aws_credentials_provider *credentials_provider;\\n struct aws_client_bootstrap *client_bootstrap;\\n struct aws_logger logger;\\n struct aws_mutex mutex;\\n struct aws_condition_variable c_var;\\n bool execution_completed;\\n struct aws_signing_config_aws signing_config;\\n const char *region;\\n enum aws_log_level log_level;\\n bool help_requested;\\n void *sub_command_data;\\n size_t expected_transfers;\\n size_t completed_transfers;\\n};\\n\\nstruct transfer_ctx {\\n struct aws_s3_meta_request *meta_request;\\n struct app_ctx *app_ctx;\\n struct aws_atomic_var bytes_done;\\n struct aws_atomic_var index;\\n struct perf_item *stats;\\n};\\n\\nvoid s_get_request_finished(\\n struct aws_s3_meta_request *meta_request,\\n const struct aws_s3_meta_request_result *meta_request_result,\\n void *user_data) {\\n\\n struct transfer_ctx *transfer_ctx = user_data;\\n struct perf_item *items = transfer_ctx->stats;\\n int i = 0;\\n\\n uint32_t x = aws_atomic_load_int(&transfer_ctx->index);\\n\\n uint64_t total_ns = last - first;\\n double total_ms = total_ns / 1000.0 / 1000.0;\\n printf("first: %ld, last: %ld, total ms: %.2lf\\\\n", first, last, total_ms);\\n\\n ssize_t total_bytes = aws_atomic_load_int(&transfer_ctx->bytes_done);\\n\\n double gbps = ((total_bytes / total_ms) * 1000) * 8 / 1000 / 1000 / 1000;\\n printf("total bytes downloaded: %ld, line speed: %.2lf Gbps\\\\n", total_bytes, gbps);\\n\\n /* write test stats */\\n int fd;\\n fd = open(TEST_RESULT_FILE, O_CREAT | O_TRUNC | O_WRONLY);\\n write(fd, items, sizeof(struct perf_item) * x);\\n close(fd);\\n\\n transfer_ctx->app_ctx->completed_transfers++;\\n\\n aws_condition_variable_notify_one(&transfer_ctx->app_ctx->c_var);\\n aws_s3_meta_request_release(transfer_ctx->meta_request);\\n aws_mem_release(transfer_ctx->app_ctx->allocator, transfer_ctx->stats);\\n aws_mem_release(transfer_ctx->app_ctx->allocator, transfer_ctx);\\n\\n return;\\n}\\n\\nint s_get_body_callback(\\n struct aws_s3_meta_request *meta_request,\\n const struct aws_byte_cursor *body,\\n uint64_t range_start,\\n void *user_data) {\\n\\n struct transfer_ctx *transfer_ctx = user_data;\\n\\n uint64_t now;\\n size_t index;\\n\\n aws_high_res_clock_get_ticks(&now);\\n index = aws_atomic_fetch_add(&transfer_ctx->index, 1);\\n (transfer_ctx->stats)[index].ns = now;\\n (transfer_ctx->stats)[index].len = body->len;\\n\\n aws_atomic_fetch_add(&transfer_ctx->bytes_done, body->len);\\n\\n return AWS_OP_SUCCESS;\\n}\\n\\nbool s_are_all_transfers_done(void *arg) {\\n\\n struct app_ctx *app_ctx = arg;\\n\\n return app_ctx->expected_transfers == app_ctx->completed_transfers;\\n}\\n\\nint s3_get(struct app_ctx *app_ctx, struct aws_s3_client *client) {\\n char source_endpoint[1024];\\n AWS_ZERO_ARRAY(source_endpoint);\\n sprintf(source_endpoint, TEST_S3_EP);\\n\\n char main_endpoint[1024];\\n AWS_ZERO_ARRAY(main_endpoint);\\n sprintf(main_endpoint, TEST_MAIN_EP);\\n\\n struct aws_byte_cursor slash_cur = aws_byte_cursor_from_c_str("/");\\n struct aws_byte_cursor keyname = aws_byte_cursor_from_c_str(TEST_FILE);\\n struct aws_byte_cursor *key = &keyname;\\n\\n struct transfer_ctx *xfer_ctx = aws_mem_calloc(app_ctx->allocator, 1, sizeof(struct transfer_ctx));\\n xfer_ctx->app_ctx = app_ctx;\\n\\n xfer_ctx->stats = aws_mem_calloc(app_ctx->allocator, 1000000, sizeof(struct perf_item));\\n aws_atomic_init_int(&xfer_ctx->bytes_done, 0);\\n aws_atomic_init_int(&xfer_ctx->index, 0);\\n\\n struct aws_s3_meta_request_options request_options = {\\n .user_data = xfer_ctx,\\n .signing_config = &app_ctx->signing_config,\\n .type = AWS_S3_META_REQUEST_TYPE_GET_OBJECT,\\n .finish_callback = s_get_request_finished,\\n .body_callback = s_get_body_callback,\\n .headers_callback = NULL,\\n .shutdown_callback = NULL,\\n .progress_callback = NULL,\\n };\\n\\n struct aws_http_header host_header = {\\n .name = g_host_header_name,\\n .value = aws_byte_cursor_from_c_str(source_endpoint),\\n };\\n\\n struct aws_http_header accept_header = {\\n .name = aws_byte_cursor_from_c_str("accept"),\\n .value = aws_byte_cursor_from_c_str("*/*"),\\n };\\n\\n struct aws_http_header user_agent_header = {\\n .name = aws_byte_cursor_from_c_str("user-agent"),\\n .value = aws_byte_cursor_from_c_str("AWS common runtime command-line client"),\\n };\\n\\n request_options.message = aws_http_message_new_request(app_ctx->allocator);\\n aws_http_message_add_header(request_options.message, host_header);\\n aws_http_message_add_header(request_options.message, accept_header);\\n aws_http_message_add_header(request_options.message, user_agent_header);\\n aws_http_message_set_request_method(request_options.message, aws_http_method_get);\\n\\n struct aws_byte_buf path_buf;\\n aws_byte_buf_init(&path_buf, app_ctx->allocator, key->len + 1);\\n aws_byte_buf_append_dynamic(&path_buf, &slash_cur);\\n aws_byte_buf_append_dynamic(&path_buf, key);\\n struct aws_byte_cursor path_cur = aws_byte_cursor_from_buf(&path_buf);\\n aws_http_message_set_request_path(request_options.message, path_cur);\\n aws_byte_buf_clean_up(&path_buf);\\n\\n struct aws_s3_meta_request *meta_request = aws_s3_client_make_meta_request(client, &request_options);\\n xfer_ctx->meta_request = meta_request;\\n\\n aws_mutex_lock(&app_ctx->mutex);\\n app_ctx->expected_transfers++;\\n aws_mutex_unlock(&app_ctx->mutex);\\n\\n aws_mutex_lock(&app_ctx->mutex);\\n aws_condition_variable_wait_pred(&app_ctx->c_var, &app_ctx->mutex, s_are_all_transfers_done, app_ctx);\\n aws_mutex_unlock(&app_ctx->mutex);\\n\\n return 0;\\n}\\n\\nint main() {\\n struct aws_allocator *allocator = aws_default_allocator();\\n aws_s3_library_init(allocator);\\n\\n struct app_ctx app_ctx;\\n AWS_ZERO_STRUCT(app_ctx);\\n app_ctx.allocator = allocator;\\n app_ctx.c_var = (struct aws_condition_variable)AWS_CONDITION_VARIABLE_INIT;\\n aws_mutex_init(&app_ctx.mutex);\\n app_ctx.expected_transfers = 0;\\n app_ctx.completed_transfers = 0;\\n\\n app_ctx.log_level = AWS_LOG_LEVEL_NONE;\\n\\n struct aws_logger_standard_options logger_options = {\\n .level = app_ctx.log_level,\\n .file = stderr,\\n };\\n\\n aws_logger_init_standard(&app_ctx.logger, app_ctx.allocator, &logger_options);\\n aws_logger_set(&app_ctx.logger);\\n\\n /* event loop */\\n struct aws_event_loop_group *event_loop_group = aws_event_loop_group_new_default(allocator, 0, NULL);\\n\\n /* resolver */\\n struct aws_host_resolver_default_options resolver_options = {\\n .el_group = event_loop_group,\\n .max_entries = 128,\\n };\\n struct aws_host_resolver *resolver = aws_host_resolver_new_default(allocator, &resolver_options);\\n\\n /* client bootstrap */\\n struct aws_client_bootstrap_options bootstrap_options = {\\n .event_loop_group = event_loop_group,\\n .host_resolver = resolver,\\n };\\n app_ctx.client_bootstrap = aws_client_bootstrap_new(allocator, &bootstrap_options);\\n if (app_ctx.client_bootstrap == NULL) {\\n printf("ERROR initializing client bootstrap\\\\n");\\n return -1;\\n }\\n\\n /* credentials */\\n struct aws_credentials_provider_chain_default_options credentials_provider_options;\\n AWS_ZERO_STRUCT(credentials_provider_options);\\n credentials_provider_options.bootstrap = app_ctx.client_bootstrap;\\n app_ctx.credentials_provider = aws_credentials_provider_new_chain_default(allocator, &credentials_provider_options);\\n\\n /* signing config */\\n aws_s3_init_default_signing_config(\\n &app_ctx.signing_config, aws_byte_cursor_from_c_str(TEST_REGION), app_ctx.credentials_provider);\\n app_ctx.signing_config.flags.use_double_uri_encode = false;\\n\\n /* s3 client */\\n struct aws_s3_client_config client_config;\\n AWS_ZERO_STRUCT(client_config);\\n client_config.client_bootstrap = app_ctx.client_bootstrap;\\n client_config.region = aws_byte_cursor_from_c_str(TEST_REGION);\\n client_config.signing_config = &app_ctx.signing_config;\\n client_config.max_active_connections_override = 0;\\n client_config.throughput_target_gbps = 100;\\n client_config.part_size = TEST_RANGE_SIZE;\\n\\n struct aws_s3_client *client = aws_s3_client_new(app_ctx.allocator, &client_config);\\n app_ctx.client = client;\\n s3_get(&app_ctx, client);\\n\\n /* release resources */\\n aws_s3_client_release(app_ctx.client);\\n aws_credentials_provider_release(app_ctx.credentials_provider);\\n aws_client_bootstrap_release(app_ctx.client_bootstrap);\\n aws_host_resolver_release(resolver);\\n aws_event_loop_group_release(event_loop_group);\\n aws_mutex_clean_up(&app_ctx.mutex);\\n\\n aws_s3_library_clean_up();\\n\\n return 0;\\n}\\n</code></pre>\\n<p>经过编译、执行后的最终的测试结果如下:</p>\n<pre><code class=\\"lang-\\">[ec2-user@ip-172-31-32-214 clang]\$ ./s3bench\\nfirst: 30633404368026, last: 30653346831918, total ms: 19942.46\\ntotal bytes downloaded: 214748364800, line speed: 86.15 Gbps\\n</code></pre>\\n<h3><a id=\\"_452\\"></a><strong>结果分析:</strong></h3>\\n<p>测试程序从收到第一个分片到最后一个分片一共花了19942.46毫秒,通过这个时间计算得到的平均下载速度是10.03 GiB/s,折合线速为 86.15 Gbps。</p>\n<p>同时通过 Amazon CloudWatch Agent 采集了操作系统的每秒接收字节数指标 (net_bytes_recv) ,并发送到 Amazon CloudWatch 做图形化分析。可以观察到测试过程中,每秒接收的字节数会有一小段缓慢上升的过程,这个阶段里由于测试程序刚刚启动,大量工作线程还在创建和初始化过程中,因此整个应用还未达到峰值的接收能力。而大约几秒种后,待工作线程初始化完毕,整个应用进入了稳定的工作状态,峰值接收速度稳定在94.73 Gbps,已经非常接近100 Gbps 的极值了。</p>\n<p><img src=\\"https://dev-media.amazoncloud.cn/85d1fc7d85bf45399f40516a56adb515_c83eb6588a39fc2a6b466c0b3b637a27.jpg\\" alt=\\"c83eb6588a39fc2a6b466c0b3b637a27.jpg\\" /></p>\n<p>图:10万兆线速测试结果</p>\n<h4><a id=\\"BONUS_1_461\\"></a><strong>BONUS #1</strong></h4>\\n<p>Amazon CRT 提供如此高的 I/O 性能,亚马逊云科技的开发人员也在积极向上层的亚马逊云科技工具集提供这种能力,其实今天在 Amazon CLI 中已经可以使用到 Amazon CRT,只是在 Amazon CLI 中使用 CRT 模式还处于 Experimental 阶段,在 Amazon CLI 中启用 CRT 模式有两个步骤:</p>\n<ol>\\n<li>\\n<p>升级到 Amazon CLI 到 v2 版本<br />\\n具体的升级步骤请参考文档:<br />\\n<a href=\\"https://docs.aws.amazon.com/cli/latest/userguide/cliv2-migration-instructions.html\\" target=\\"_blank\\">https://docs.aws.amazon.com/cli/latest/userguide/cliv2-migration-instructions.html</a></p>\\n</li>\n<li>\\n<p>打开 CRT 模式</p>\n</li>\\n</ol>\n<pre><code class=\\"lang-\\">aws configure set default.s3.preferred_transfer_client crt\\n</code></pre>\\n<p>CRT 模式的详细说明请参考文档:<br />\\n<a href=\\"https://awscli.amazonaws.com/v2/documentation/api/latest/topic/s3-config.html\\" target=\\"_blank\\">https://awscli.amazonaws.com/v2/documentation/api/latest/topic/s3-config.html</a></p>\\n<p>设置完毕后, 运行 s3 cp 命令启动下载,发现速度已经有了明显的提升,在我们的测试实例上稳定在 2.0 GiB/s。</p>\n<pre><code class=\\"lang-\\">[ec2-user@ip-172-31-40-21 ~]\$ aws s3 cp s3://testbucket/200_test.file /mnt/200_test.file\\nCompleted 29.6 GiB/200.0 GiB (2.0 GiB/s) with 1 file(s) remaining\\n</code></pre>\\n<p>2 GiB/s 虽不及原生 Amazon CRT 能够达到的10 GiB/s,但对大部分使用场景来说已经够用,简单替换便能大幅提升性能,不失为一个简单的好办法。</p>\n<p>在好奇心的驱使下,我们分析了一下开启 CRT 模式的 Amazon CLI 遇到的瓶颈。在 Amazon CLI 稳定到下载峰值的时候,通过 gdb dump 了执行程序的调用链,我们看到,绝大部分的工作现场都处于 epoll_wait() 等待的状态。</p>\n<pre><code class=\\"lang-\\">(gdb) info thread\\n Id Target Id Frame\\n* 1 Thread 0x7f467761e740 (LWP 18862) 0x00007f467645ea46 in do_futex_wait.constprop ()\\n from /lib64/libpthread.so.0\\n 2 Thread 0x7f45d8dfa700 (LWP 18904) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 3 Thread 0x7f45661fc700 (LWP 18926) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 4 Thread 0x7f45da1fc700 (LWP 18902) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 5 Thread 0x7f46561fc700 (LWP 18873) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 6 Thread 0x7f4657fff700 (LWP 18870) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 7 Thread 0x7f45d97fb700 (LWP 18903) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 8 Thread 0x7f4664e86700 (LWP 18868) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 9 Thread 0x7f46161fc700 (LWP 18890) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 10 Thread 0x7f45975fe700 (LWP 18912) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 11 Thread 0x7f4596bfd700 (LWP 18913) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 12 Thread 0x7f45db5fe700 (LWP 18900) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 13 Thread 0x7f44c21fc700 (LWP 18962) 0x00007f467645ea46 in do_futex_wait.constprop ()\\n from /lib64/libpthread.so.0\\n 14 Thread 0x7f451d7fb700 (LWP 18945) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 15 Thread 0x7f461ffff700 (LWP 18882) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 16 Thread 0x7f453d7fb700 (LWP 18939) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 17 Thread 0x7f457d7fb700 (LWP 18921) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 18 Thread 0x7f464f5fe700 (LWP 18876) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 19 Thread 0x7f45957fb700 (LWP 18915) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 20 Thread 0x7f4614dfa700 (LWP 18892) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n 21 Thread 0x7f453ebfd700 (LWP 18937) 0x00007f4676d3088c in epoll_wait () from /lib64/libc.so.6\\n</code></pre>\\n<p>而 Amazon CLI 的主线程锁在信号量上,这是 python 著名的 GIL,关于 python GIL 这里不再赘述,Amazon CLI V2 仍然是基于 python 的实现,因此无法完全规避语言本身带来的多线程性能瓶颈。</p>\n<pre><code class=\\"lang-\\">(gdb) thread 1\\n[Switching to thread 1 (Thread 0x7f467761e740 (LWP 18862))]\\n#0 0x00007f467645ea46 in do_futex_wait.constprop () from /lib64/libpthread.so.0\\n(gdb) bt\\n#0 0x00007f467645ea46 in do_futex_wait.constprop () from /lib64/libpthread.so.0\\n#1 0x00007f467645eb22 in __new_sem_wait_slow.constprop.0 () from /lib64/libpthread.so.0\\n#2 0x00007f46768812ff in PyThread_acquire_lock_timed (lock=lock@entry=0x561a67fcf390,\\n microseconds=microseconds@entry=-1000000, intr_flag=intr_flag@entry=1) at Python/thread_pthread.h:483\\n#3 0x00007f46768dcaf4 in acquire_timed (timeout=-1000000000, lock=0x561a67fcf390)\\n at ./Modules/_threadmodule.c:63\\n#4 lock_PyThread_acquire_lock (self=0x7f4664407ea0, args=<optimized out>, kwds=<optimized out>)\\n at ./Modules/_threadmodule.c:146\\n#5 0x00007f46767368a2 in method_vectorcall_VARARGS_KEYWORDS (func=0x7f46775c92c0, args=0x561a67ee7f48,\\n nargsf=<optimized out>, kwnames=<optimized out>) at Objects/descrobject.c:348\\n#6 0x00007f46766d80a8 in _PyObject_VectorcallTstate (kwnames=<optimized out>, nargsf=<optimized out>,\\n args=<optimized out>, callable=<optimized out>, tstate=<optimized out>)\\n at ./Include/cpython/abstract.h:118\\n#7 PyObject_Vectorcall (kwnames=<optimized out>, nargsf=<optimized out>, args=<optimized out>,\\n callable=<optimized out>) at ./Include/cpython/abstract.h:127\\n#8 trace_call_function (kwnames=<optimized out>, nargs=<optimized out>, args=<optimized out>,\\n func=<optimized out>, tstate=<optimized out>) at Python/ceval.c:5058\\n#9 call_function (kwnames=0x0, oparg=<optimized out>, pp_stack=<synthetic pointer>, tstate=0x561a674afe40)\\n at Python/ceval.c:5074\\n#10 _PyEval_EvalFrameDefault (tstate=<optimized out>, f=<optimized out>, throwflag=<optimized out>)\\n at Python/ceval.c:3506\\n#11 0x00007f467682aec1 in _PyEval_EvalFrame (throwflag=0, f=0x561a67ee7db0, tstate=0x561a674afe40)\\n at ./Include/internal/pycore_ceval.h:40\\n</code></pre>\\n<p>但是,还是那句话,2 GiB/s 的下载速度对绝大部分使用场景已经够用,而且轻松配置几下就能获得,为什么不用呢?</p>\n<h4><a id=\\"BONUS_2_541\\"></a><strong>BONUS #2</strong></h4>\\n<p>同样,在好奇心的驱使下,我们也验证了,自带无畏并发特性的 Rust 语言,在 S3 下载场景中的表现。验证代码如下:</p>\n<pre><code class=\\"lang-\\">use aws_config::meta::region::RegionProviderChain;\\nuse aws_sdk_s3::{Client, Region, PKG_VERSION};\\nuse aws_sdk_s3::Endpoint;\\nuse http::Uri;\\nuse tokio::runtime::{Builder, Runtime};\\nuse tokio::fs::File;\\nuse tokio::io::AsyncWriteExt;\\nuse tokio::io::AsyncSeekExt;\\nuse tokio::io::SeekFrom;\\nuse tokio::fs::OpenOptions;\\nuse tokio::time::{Duration, Instant};\\nuse std::error::Error;\\nuse indicatif::{ProgressBar, ProgressStyle};\\n\\nmacro_rules! thread_tasks {\\n (\$tasks:expr, \$manager:expr) => {{\\n let mut _tasks = Vec::new();\\n for i in 0..\$manager.threads {\\n let mut thread_tasks = Vec::new();\\n _tasks.push(thread_tasks);\\n }\\n let mut pos = 0;\\n for task in \$tasks {\\n let i = pos % \$manager.threads;\\n _tasks[i].push(task);\\n pos += 1;\\n }\\n _tasks\\n }}\\n}\\n\\ntype Range = (isize, isize);\\n\\ntype GetTask = Range;\\n\\n#[derive(Clone)]\\nstruct TransferManager {\\n s3: Client,\\n threads: usize,\\n chunks: isize,\\n bucket: String,\\n key: String,\\n filename: String,\\n objsz: isize,\\n forcewrite: bool,\\n bar: ProgressBar,\\n}\\n\\nimpl TransferManager {\\n\\n pub async fn new(is_get: bool, forcewrite: bool, filename: String, bucket: String, key: String, thread_cnt: usize, chunks: isize, endpoint: Option<String>) -> Self {\\n\\n let region_provider = RegionProviderChain::default_provider().or_else("ap-northeast-1");\\n let shared_config = aws_config::from_env().region(region_provider).load().await;\\n\\n let client = if endpoint.is_some() {\\n let s3_config = aws_sdk_s3::config::Builder::from(&shared_config)\\n .endpoint_resolver(\\n Endpoint::immutable(Uri::try_from(endpoint.unwrap()).expect("error: bad endpoint")),\\n )\\n .build();\\n Client::from_conf(s3_config)\\n } else {\\n Client::new(&shared_config)\\n };\\n\\n let mut manager = Self {\\n s3: client,\\n threads: thread_cnt,\\n chunks: chunks,\\n bucket: bucket.clone(),\\n key: key.clone(),\\n filename: filename.clone(),\\n objsz: 0,\\n forcewrite: forcewrite,\\n bar: ProgressBar::new(0),\\n };\\n\\n let mut objsz = 0;\\n if is_get {\\n objsz = manager.head_object().await;\\n if forcewrite {\\n let mut f = File::create(manager.filename.clone()).await.expect("failed to create file");\\n f.set_len(objsz as u64).await.expect("failed to set local file len");\\n }\\n } else {\\n objsz = manager.get_file_size().await;\\n }\\n\\n let bar = ProgressBar::new(objsz as u64);\\n bar.set_style(ProgressStyle::with_template("{spinner:.green} [{elapsed_precise}] [{wide_bar:.cyan/blue}] {bytes}/{total_bytes} ({eta}) ({bytes_per_sec})")\\n .unwrap()\\n .progress_chars("#>-"));\\n\\n manager.objsz = objsz;\\n manager.bar = bar;\\n manager\\n }\\n\\n pub fn alloc_get_tasks(&self, tasks: &mut Vec<GetTask>) {\\n\\n let mut remains = self.objsz;\\n let mut offset = 0;\\n while remains > 0 {\\n let mut range: Range = (0, 0);\\n if remains > self.chunks {\\n range = (offset, offset + self.chunks - 1);\\n } else {\\n range = (offset, offset + remains - 1);\\n }\\n let task = range;\\n tasks.push(task);\\n offset += self.chunks;\\n remains -= self.chunks;\\n }\\n }\\n\\n pub async fn do_get_tasks(&self) {\\n\\n let mut tasks = Vec::new();\\n\\n self.alloc_get_tasks(&mut tasks);\\n let mut thr_tasks: Vec<Vec<GetTask>> = thread_tasks!(tasks, self);\\n\\n let mut joins = Vec::new();\\n while let Some(mut thr_taskq) = thr_tasks.pop() {\\n let mut m = self.clone();\\n let bar = self.bar.clone();\\n let join = tokio::spawn(async move {\\n while let Some(task) = thr_taskq.pop() {\\n let res = m.download_object(task).await;\\n if res.is_err() {\\n println!("download error: {:?}", res);\\n }\\n bar.inc(res.unwrap() as u64);\\n }\\n 0\\n });\\n joins.push(join);\\n }\\n\\n let instant = Instant::now();\\n self.bar.reset();\\n for join in joins {\\n join.await;\\n }\\n\\n let diff = instant.elapsed();\\n let bw = ((self.objsz as u128 / diff.as_millis()) as f64 / (1024.0 * 1024.0 * 1024.0)) * 1000.0;\\n self.bar.finish();\\n }\\n\\n pub async fn download_object(&mut self, range: GetTask) -> Result<isize, Box<dyn Error>> {\\n let resp = self.s3\\n .get_object()\\n .bucket(&self.bucket)\\n .key(&self.key)\\n .range(format!("bytes={}-{}", range.0, range.1))\\n .send()\\n .await?;\\n let data = resp.body.collect().await.expect("error reading data");\\n let mut bytes = data.into_bytes();\\n\\n if !self.forcewrite {\\n return Ok(bytes.len() as isize);\\n }\\n\\n let mut file = OpenOptions::new()\\n .write(true)\\n .open(self.filename.clone())\\n .await?;\\n\\n file.seek(SeekFrom::Start(range.0 as u64)).await?;\\n file.write_all(&bytes).await?;\\n\\n Ok(bytes.len() as isize)\\n }\\n\\n pub async fn head_object(&self) -> isize {\\n let resp = self.s3\\n .head_object()\\n .bucket(&self.bucket)\\n .key(&self.key)\\n .send()\\n .await\\n .expect("failed to get object size from S3");\\n resp.content_length() as isize\\n }\\n\\n pub async fn get_file_size(&self) -> isize {\\n let attr = tokio::fs::metadata(self.filename.clone()).await.expect("failed to get file size");\\n attr.len() as isize\\n }\\n}\\n\\nfn main() -> Result<(), Box<dyn Error>> {\\n\\n let is_get = true;\\n let mut region = "ap-northeast-1".to_string();\\n let mut bucket = "testbucket".to_string();\\n let mut object = "200G_test.file".to_string();\\n let mut filename = "200G_test.file".to_string();\\n let mut forcewrite = false;\\n let mut threadpool = 30;\\n let mut parallel_tasks = 300;\\n let mut chunksize = 8 * 1024 * 1024;\\n let mut endpoint = None;\\n\\n let rt = Builder::new_multi_thread()\\n .worker_threads(threadpool)\\n .enable_all()\\n .build()\\n .unwrap();\\n\\n rt.block_on(async {\\n let mut tm = TransferManager::new(is_get, forcewrite, filename, bucket, object, parallel_tasks, chunksize, endpoint).await;\\n\\n tm.do_get_tasks().await;\\n });\\n Ok(())\\n}\\n</code></pre>\\n<p>运行结果如下:</p>\n<pre><code class=\\"lang-\\">[ec2-user@ip-172-31-32-214 src]\$./s3perf\\n [00:00:24] [#######################################################################] 200.00 GiB/200.00 GiB (0s) (8.24 GiB/s)\\n [ec2-user@ip-172-31-32-214 src]\$\\n</code></pre>\\n<p>200 GiB 的对象下载花了24秒,整体下载速度为 8.24 GiB/s,而在更客观的 CloudWatch 监控数据中我们看到了峰值<strong>80.62 Gbps</strong>。</p>\\n<p><img src=\\"https://dev-media.amazoncloud.cn/c562a1a70ddc45439dc0e9999e4ec947_18e093990b7a3b04bc86f46d14054bdd.png\\" alt=\\"18e093990b7a3b04bc86f46d14054bdd.png\\" /></p>\n<p>从结果看到,Rust 语言的表现也非常优秀。</p>\n<h3><a id=\\"_779\\"></a><strong>总结</strong></h3>\\n<p>我们目标是通过验证的工作,帮助大家了解在 EC2 到 S3 之间实现逼近100 Gbps 线速数据传输的一切细节,回归问题的本质,对于客户实际应用场景来说,是否真正需要追求极限性能,如何利用好现有的资源达到应用最优的效果,是值得思考的问题。</p>\n<p>我们的建议是:</p>\n<ol>\\n<li>\\n<p>应该首先分析应用的场景,确定极限性能的必要性,对于绝大部分应用场景来说,目前亚马逊云科技提供的 CLI 或者 SDK 已经可以满足客户的需求,或者通过一定的参数调整即可满足对性能的要求。</p>\n</li>\\n<li>\\n<p>现有工具和方法可以满足应用需求的前提下,不必盲目追求极限的性能,毕竟使用 Amazon CRT 改造应用需要重构代码及应用,会带来额外的改造成本和测试集成的成本。</p>\n</li>\\n<li>\\n<p>我们验证的场景是 EC2 上单应用进程对 S3 上单个大对象的下载,在更具普适性的场景中,使用多进程同时下载多个对象方式也是有效提高并发度,进而提高系统整体吞吐率的有效方式。</p>\n</li>\\n<li>\\n<p>对于确实需要极限性能的场景,建议您尽早考虑使用 Amazon CRT 来重构核心的模块,实现最高的性能。</p>\n</li>\\n</ol>\n<p>随着 Amazon CRT 的不断发展,我们相信它的易用性以及与现有语言和应用生态的集成会做的越来越好,我们也期待有越来越多的客户使用 Amazon CRT 来构建高性能的应用。</p>\n<h3><a id=\\"_794\\"></a><strong>本篇作者</strong></h3>\\n<p><img src=\\"https://dev-media.amazoncloud.cn/e323181ec2df42ae99562b8bc4acfbd4_2701043c5747cb14579cd9853bf52193.jpg\\" alt=\\"2701043c5747cb14579cd9853bf52193.jpg\\" /></p>\n<p><strong>戴逸洋</strong><br />\\n亚马逊云科技数据存储资深架构师,致力于推广存储技术在云上的各种最佳实践。</p>\n<p><a href=\\"https://aws.amazon.com/cn/blogs/china/pushing-the-data-transfer-from-amazon-ec2-to-amazon-s3-to-100gbps-line-speed/?sc_channel=sm&sc_campaign=blog&sc_publisher=wechatdev&sc_detail=\\" target=\\"_blank\\">阅读原文</a></p>\n"}

将 Amazon EC2 到 Amazon S3 的数据传输推向100Gbps 线速

亚马逊云科技

Amazon Simple Storage Service (S3)

Amazon EC2

0

0 0

0亚马逊云科技解决方案 基于行业客户应用场景及技术领域的解决方案

联系亚马逊云科技专家

相关产品

相关产品目录

相关产品

相关产品亚马逊云科技解决方案 基于行业客户应用场景及技术领域的解决方案

联系亚马逊云科技专家

亚马逊云科技解决方案

基于行业客户应用场景及技术领域的解决方案

联系专家

0

目录

分享

分享 点赞

点赞 收藏

收藏 目录

目录立即关注

亚马逊云开发者

公众号

User Group

公众号

亚马逊云科技

官方小程序

“AWS” 是 “Amazon Web Services” 的缩写,在此网站不作为商标展示。

立即关注

亚马逊云开发者

公众号

User Group

公众号

亚马逊云科技

官方小程序

“AWS” 是 “Amazon Web Services” 的缩写,在此网站不作为商标展示。

立即关注

亚马逊云开发者

公众号

User Group

公众号

亚马逊云科技

官方小程序

“AWS” 是 “Amazon Web Services” 的缩写,在此网站不作为商标展示。